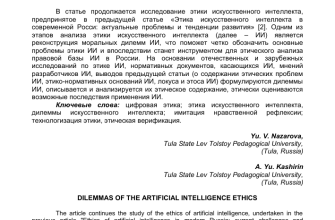

- Дроны с ИИ: Бомба замедленного действия или технологический прорыв? Разбираемся в этических дилеммах

- Этические риски и вызовы в разработке ИИ для дронов

- Конфиденциальность под прицелом: Как защитить личное пространство в эпоху дронов

- Кто виноват? Проблема ответственности за действия дронов с ИИ

- Реальные кейсы и этические дилеммы использования ИИ в дронах

- Автономное оружие: Переход красной линии?

- Как найти баланс: Рекомендации по этичному развитию ИИ для дронов

Дроны с ИИ: Бомба замедленного действия или технологический прорыв? Разбираемся в этических дилеммах

Мы живем в эпоху стремительного развития искусственного интеллекта (ИИ), и его интеграция в различные сферы нашей жизни становится все более заметной. Одной из самых перспективных и одновременно вызывающих опасения областей применения ИИ являются беспилотные летательные аппараты, или дроны. Эти устройства, оснащенные интеллектуальными системами, открывают огромные возможности, но и поднимают серьезные этические вопросы, которые требуют тщательного рассмотрения.

В этой статье мы погрузимся в мир этических дилемм, связанных с разработкой и использованием ИИ для дронов. Мы рассмотрим различные аспекты, начиная от вопросов конфиденциальности и заканчивая проблемами ответственности за действия автономных систем. Наша цель – не просто перечислить существующие проблемы, но и предложить возможные пути их решения, чтобы обеспечить ответственное и этичное развитие этой многообещающей технологии.

Этические риски и вызовы в разработке ИИ для дронов

Разработка ИИ для дронов сопряжена с рядом уникальных этических вызовов. В отличие от других систем ИИ, дроны обладают способностью перемещаться в физическом пространстве, взаимодействовать с окружающей средой и даже применять силу. Это означает, что ошибки в алгоритмах или неверные решения, принятые дроном, могут иметь серьезные последствия, включая причинение вреда людям или имуществу.

Давайте рассмотрим некоторые из наиболее важных этических рисков, связанных с разработкой ИИ для дронов:

- Конфиденциальность: Дроны, оснащенные камерами и другими датчиками, могут собирать огромные объемы данных о людях и их деятельности. Это создает угрозу нарушения конфиденциальности и злоупотребления информацией.

- Ответственность: Кто несет ответственность за действия автономного дрона, особенно если он совершает ошибку или причиняет вред? Разработчик? Оператор? Или сам дрон?

- Предвзятость: Алгоритмы ИИ могут быть предвзятыми, отражая предубеждения, присутствующие в данных, на которых они обучались. Это может привести к дискриминации и несправедливому отношению к определенным группам людей.

- Автономизация оружия: Разработка автономного оружия на базе дронов вызывает серьезные опасения, поскольку такие системы могут принимать решения о применении силы без участия человека.

- Безопасность: Дроны могут быть взломаны или использованы в злонамеренных целях, например, для шпионажа, саботажа или совершения террористических актов.

Конфиденциальность под прицелом: Как защитить личное пространство в эпоху дронов

Представьте себе мир, где дроны, оснащенные мощными камерами и системами распознавания лиц, постоянно патрулируют улицы, собирая информацию о каждом вашем шаге. Звучит как антиутопия, не правда ли? Однако, с развитием технологий ИИ для дронов, эта перспектива становится все более реальной.

Дроны могут собирать огромное количество данных, включая:

- Видео- и фотосъемку

- Аудиозаписи

- Геолокацию

- Информацию о мобильных устройствах

Эта информация может быть использована для отслеживания перемещений людей, анализа их поведения, выявления связей и даже предсказания их будущих действий. Такой уровень слежки может иметь серьезные последствия для свободы и частной жизни граждан.

Чтобы защитить конфиденциальность в эпоху дронов, необходимо принять ряд мер, включая:

- Разработку строгих правил и законов, регулирующих использование дронов и сбор данных.

- Внедрение технических средств защиты конфиденциальности, таких как шифрование данных и анонимизация информации.

- Повышение осведомленности общественности о рисках, связанных с использованием дронов, и обучение людей способам защиты своей конфиденциальности.

Кто виноват? Проблема ответственности за действия дронов с ИИ

Представьте себе ситуацию: автономный дрон, доставляющий посылку, теряет управление и врезается в автомобиль, причинив ущерб. Кто несет ответственность за этот инцидент? Разработчик дрона? Оператор, который его запустил? Или сам дрон, оснащенный ИИ?

Проблема ответственности за действия автономных систем ИИ является одной из самых сложных и спорных в сфере этики ИИ. Традиционные концепции ответственности, основанные на вине и причинно-следственной связи, оказываются неприменимыми к ситуациям, когда решения принимаются автономными системами.

Существуют различные подходы к решению этой проблемы, включая:

- Строгая ответственность: Разработчик или оператор несет ответственность за любой ущерб, причиненный дроном, независимо от вины.

- Ответственность за дизайн: Разработчик несет ответственность за ущерб, причиненный из-за дефектов в конструкции или алгоритмах дрона.

- Ответственность за надзор: Оператор несет ответственность за ущерб, причиненный из-за ненадлежащего надзора за дроном.

Выбор подходящего подхода к ответственности зависит от конкретных обстоятельств и рисков, связанных с использованием дронов. Важно найти баланс между защитой прав потерпевших и стимулированием инноваций в сфере ИИ.

Реальные кейсы и этические дилеммы использования ИИ в дронах

Давайте рассмотрим несколько реальных примеров, которые иллюстрируют этические дилеммы, связанные с использованием ИИ в дронах:

| Сфера применения | Этические дилеммы |

|---|---|

| Сельское хозяйство | Использование дронов для мониторинга полей и применения пестицидов может повысить урожайность, но также может нанести вред окружающей среде и здоровью людей. |

| Правоохранительные органы | Использование дронов для наблюдения за преступностью может повысить эффективность работы полиции, но также может привести к нарушению прав граждан и злоупотреблению властью. |

| Доставка | Использование дронов для доставки посылок может ускорить процесс доставки и снизить затраты, но также может создать угрозу безопасности и нарушить приватность. |

| Поиск и спасение | Использование дронов для поиска пропавших людей может спасти жизни, но также может создать риск для безопасности спасателей и нарушить конфиденциальность пострадавших. |

"Технологии – это не добро и не зло. Они нейтральны, пока мы не решим, как их использовать."

– Саймон Синек

Автономное оружие: Переход красной линии?

Одним из самых спорных вопросов в сфере этики ИИ является разработка автономного оружия, способного принимать решения о применении силы без участия человека. Дроны, оснащенные системами ИИ, являются потенциальной платформой для создания такого оружия.

Сторонники разработки автономного оружия утверждают, что такие системы могут быть более точными и эффективными, чем люди, и могут снизить риск жертв среди военнослужащих. Однако, противники опасаются, что автономное оружие может привести к непредсказуемым последствиям и нарушению международного гуманитарного права.

Многие эксперты и организации призывают к запрету разработки и использования автономного оружия, считая, что решение о применении силы должно всегда оставаться за человеком.

Как найти баланс: Рекомендации по этичному развитию ИИ для дронов

Разработка и использование ИИ для дронов – это сложная задача, требующая учета множества факторов и интересов. Чтобы обеспечить этичное и ответственное развитие этой технологии, необходимо придерживаться следующих рекомендаций:

- Разрабатывать строгие этические кодексы и стандарты: Необходимо установить четкие правила и нормы, регулирующие разработку и использование ИИ для дронов, с учетом принципов конфиденциальности, ответственности, прозрачности и справедливости.

- Проводить оценку этических рисков: Перед внедрением новых технологий необходимо проводить тщательную оценку этических рисков и принимать меры по их минимизации.

- Обеспечивать прозрачность и подотчетность: Алгоритмы ИИ должны быть понятными и объяснимыми, а решения, принимаемые дронами, должны быть подотчетны.

- Привлекать общественность к обсуждению: Необходимо вовлекать общественность в обсуждение этических вопросов, связанных с использованием ИИ для дронов, и учитывать мнение различных заинтересованных сторон.

- Инвестировать в исследования и образование: Необходимо инвестировать в исследования в области этики ИИ и образование специалистов, способных разрабатывать и использовать ИИ ответственно.

Мы верим, что, придерживаясь этих рекомендаций, мы сможем использовать потенциал ИИ для дронов во благо общества, минимизируя риски и обеспечивая соблюдение этических принципов;

Подробнее

| ИИ для дронов в сельском хозяйстве | Этика использования дронов в городах | Ответственность за ошибки дронов | Приватность и дроны с камерами | Автономное оружие на базе дронов |

|---|---|---|---|---|

| Регулирование использования дронов ИИ | Предвзятость алгоритмов в дронах | Этические кодексы для разработчиков дронов | Дроны для наблюдения и приватность | ИИ дроны в поисково-спасательных операциях |