ИИ и автоматическая дискриминация: Как избежать предвзятости в алгоритмах?

Мир искусственного интеллекта развивается с головокружительной скоростью, проникая во все сферы нашей жизни. От рекомендаций фильмов до анализа кредитной истории – ИИ становится незаменимым помощником. Но вместе с тем, как у нас, возникает вопрос: а не несет ли эта мощная технология скрытые риски? Один из самых серьезных – это так называемая "автоматическая дискриминация", когда алгоритмы, сами того не желая, начинают воспроизводить и усиливать существующие в обществе предрассудки.

Мы, как активные пользователи и наблюдатели за развитием ИИ, считаем важным разобраться в этой проблеме и понять, как можно минимизировать ее негативные последствия. Ведь будущее, в котором ИИ влияет на ключевые решения, должно быть справедливым и равноправным для всех.

Что такое автоматическая дискриминация в ИИ?

Автоматическая дискриминация – это ситуация, когда алгоритмы ИИ, обученные на исторических данных, содержащих предвзятости, начинают принимать решения, дискриминирующие определенные группы людей по признакам расы, пола, возраста, религии и т.д. Важно понимать, что это не всегда происходит намеренно. Зачастую, алгоритмы просто "выучивают" существующие закономерности в данных, даже если эти закономерности отражают несправедливое отношение к определенным группам.

Представьте себе, что ИИ используется для отбора кандидатов на работу. Если исторические данные о найме содержат информацию о том, что на определенные должности чаще принимали мужчин, то алгоритм может начать отдавать предпочтение кандидатам мужского пола, даже если их квалификация ниже, чем у женщин. Это и есть пример автоматической дискриминации.

Примеры автоматической дискриминации

Вот несколько конкретных примеров, демонстрирующих, как автоматическая дискриминация может проявляться в различных сферах:

- Распознавание лиц: Исследования показали, что системы распознавания лиц хуже распознают лица людей с темной кожей, что может приводить к ошибкам и несправедливому отношению.

- Кредитный скоринг: Алгоритмы, используемые для оценки кредитоспособности, могут дискриминировать определенные группы населения, например, жителей бедных районов, даже если они имеют хорошую кредитную историю.

- Системы правосудия: ИИ, применяемый для прогнозирования вероятности совершения преступления, может необоснованно завышать риски для определенных этнических групп, что приводит к предвзятому отношению со стороны правоохранительных органов.

Источники предвзятости в ИИ

Чтобы эффективно бороться с автоматической дискриминацией, важно понимать, откуда она берется. Основные источники предвзятости в ИИ:

- Предвзятые данные: Как мы уже говорили, если данные, на которых обучается ИИ, содержат предрассудки, то и алгоритм будет их воспроизводить.

- Предвзятость разработчиков: Личные убеждения и взгляды разработчиков могут неосознанно влиять на выбор данных, алгоритмов и критериев оценки.

- Неполные данные: Если данные не отражают разнообразие населения, то ИИ может делать неверные выводы о тех группах, которые недостаточно представлены.

- Неправильный выбор метрик: Выбор метрик для оценки работы ИИ может приводить к тому, что алгоритм будет оптимизироваться под определенные группы населения, игнорируя интересы других.

"Искусственный интеллект может стать величайшим благом для человечества, но только если мы будем осторожны и внимательны к его потенциальным рискам. Мы должны сделать все возможное, чтобы избежать автоматической дискриминации и обеспечить справедливое и равноправное будущее для всех."

― Стивен Хокинг

Как избежать автоматической дискриминации?

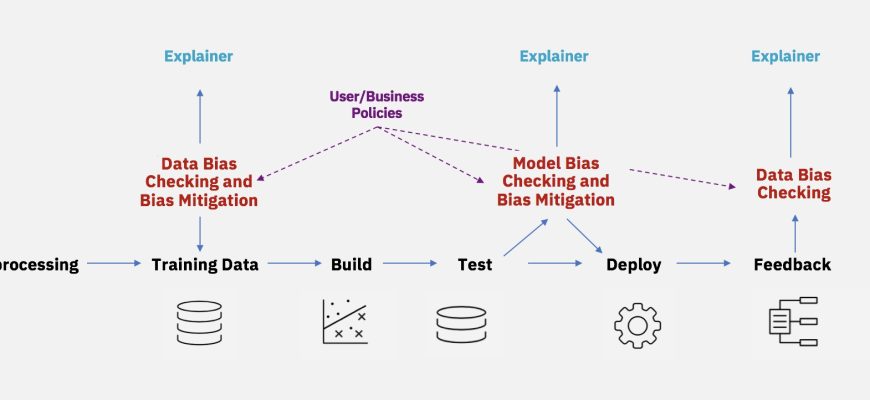

Борьба с автоматической дискриминацией – это сложная, но решаемая задача. Она требует комплексного подхода, включающего в себя:

- Тщательный анализ данных: Необходимо внимательно изучать данные, на которых обучается ИИ, и выявлять возможные предвзятости.

- Использование техник дебиасинга: Существуют специальные методы, которые позволяют уменьшить предвзятость в данных и алгоритмах.

- Разнообразие в командах разработчиков: Важно, чтобы команды, создающие ИИ, были разнообразными по составу, чтобы разные точки зрения учитывались при разработке.

- Прозрачность и объяснимость: Алгоритмы ИИ должны быть прозрачными и понятными, чтобы можно было понять, как они принимают решения и выявить возможные ошибки.

- Мониторинг и аудит: Необходимо постоянно мониторить работу ИИ и проводить аудит, чтобы выявлять и устранять случаи автоматической дискриминации.

- Разработка этических принципов: Важно разработать четкие этические принципы, которые будут регулировать разработку и использование ИИ.

Конкретные шаги по борьбе с предвзятостью

Давайте рассмотрим несколько конкретных шагов, которые мы можем предпринять для борьбы с автоматической дискриминацией:

- Сбор и анализ данных:

- Собирайте данные из разных источников, чтобы обеспечить репрезентативность.

- Проводите аудит данных на предмет предвзятости.

- Используйте техники дополнения данных, чтобы увеличить количество данных для недостаточно представленных групп.

- Разработка алгоритмов:

- Используйте алгоритмы, которые меньше подвержены предвзятости.

- Применяйте техники дебиасинга, такие как перевзвешивание, повторная выборка и регуляризация.

- Оценивайте работу алгоритмов на разных группах населения, чтобы выявить возможные случаи дискриминации.

- Мониторинг и аудит:

- Постоянно мониторьте работу ИИ и выявляйте случаи автоматической дискриминации.

- Проводите регулярный аудит алгоритмов и данных.

- Используйте метрики, которые учитывают интересы всех групп населения.

Будущее ИИ и справедливость

Мы уверены, что будущее ИИ может быть светлым и справедливым, если мы будем уделять достаточно внимания проблеме автоматической дискриминации. Мы должны помнить, что ИИ – это всего лишь инструмент, и то, как он будет использоваться, зависит от нас. Мы должны сделать все возможное, чтобы ИИ служил интересам всего человечества, а не усиливал существующие неравенства.

Борьба с автоматической дискриминацией – это не только техническая задача, но и этическая. Мы должны задавать себе вопросы о том, какие ценности мы хотим заложить в ИИ, и как мы можем обеспечить, чтобы он использовался во благо всех людей.

Подробнее

| Предвзятость в ИИ | Алгоритмическая дискриминация | Этика ИИ | Справедливость в ИИ | Дебиасинг данных |

|---|---|---|---|---|

| Распознавание лиц и раса | Кредитный скоринг и дискриминация | ИИ в правосудии | Прозрачность ИИ | Мониторинг ИИ |