- ИИ и предвзятость в распознавании жестов: Как избежать дискриминации в технологиях будущего

- Почему ИИ ошибается: Корни предвзятости в данных и алгоритмах

- Примеры предвзятости в системах распознавания жестов

- Последствия предвзятости: От неудобства до дискриминации

- Как бороться с предвзятостью: Практические рекомендации

- Инструменты и ресурсы для борьбы с предвзятостью

- Будущее распознавания жестов: К справедливому и инклюзивному ИИ

ИИ и предвзятость в распознавании жестов: Как избежать дискриминации в технологиях будущего

Мы живем в эпоху, когда искусственный интеллект (ИИ) проникает во все сферы нашей жизни. От умных домов до автономных автомобилей, ИИ обещает сделать нашу жизнь проще и удобнее. Однако, вместе с этим прогрессом возникает и ряд серьезных вопросов, касающихся этики и справедливости. Одной из наиболее актуальных проблем является предвзятость в системах ИИ, особенно в тех, которые занимаются распознаванием жестов.

В этой статье мы, опираясь на наш собственный опыт и исследования, постараемся разобраться, почему возникает предвзятость в системах распознавания жестов, какие последствия она может иметь и как мы можем избежать дискриминации в технологиях будущего. Мы коснемся не только теоретических аспектов, но и приведем конкретные примеры и практические рекомендации.

Почему ИИ ошибается: Корни предвзятости в данных и алгоритмах

Причины предвзятости в системах распознавания жестов кроются в двух основных факторах: данных, на которых обучаются алгоритмы, и самих алгоритмах. Начнем с данных. Представьте себе, что вы учите ребенка различать яблоки и груши, показывая ему только красные яблоки и зеленые груши. Что произойдет, если вы дадите ему зеленое яблоко? Скорее всего, он назовет его грушей. То же самое происходит и с ИИ.

Если обучающие данные для системы распознавания жестов содержат недостаточное количество примеров жестов, выполняемых людьми разных рас, полов, возрастов и физических особенностей, то система будет плохо распознавать жесты, выполняемые людьми, не представленными в обучающей выборке. Например, если система обучена преимущественно на жестах, выполняемых мужчинами европейской внешности, то она может хуже распознавать жесты, выполняемые женщинами африканского происхождения.

Но дело не только в разнообразии данных. Важно также, чтобы данные были правильно размечены. Если в обучающей выборке есть ошибки в разметке жестов, то система будет учиться на этих ошибках и, соответственно, будет ошибаться в реальных условиях. Например, если жест "приветствие" случайно помечен как "прощание" в некоторых примерах, то система может путать эти два жеста.

Вторая причина предвзятости кроется в самих алгоритмах. Некоторые алгоритмы, используемые в системах распознавания жестов, могут быть более склонны к предвзятости, чем другие. Например, алгоритмы, основанные на нейронных сетях, могут "запоминать" закономерности в данных, которые на самом деле не являются значимыми. Это может приводить к тому, что система будет принимать решения на основе стереотипов, а не на основе реальных характеристик жеста.

Примеры предвзятости в системах распознавания жестов

Предвзятость в системах распознавания жестов может проявляться в самых разных ситуациях. Вот несколько примеров, с которыми мы сталкивались лично или о которых слышали от коллег:

- Система распознавания языка жестов хуже распознает жесты, выполняемые людьми с темным цветом кожи.

- Система, управляющая роботом-ассистентом, не понимает жесты пожилых людей.

- Автоматизированная система обучения жестовому языку испытывает трудности с распознаванием жестов, выполняемых детьми.

- Система безопасности, использующая распознавание жестов для идентификации личности, чаще ошибочно идентифицирует людей с инвалидностью.

Эти примеры показывают, что предвзятость в системах распознавания жестов может иметь серьезные последствия, особенно для тех, кто уже находится в уязвимом положении.

Последствия предвзятости: От неудобства до дискриминации

Последствия предвзятости в системах распознавания жестов могут быть разными, в зависимости от контекста применения. В одних случаях это может быть просто неудобство, а в других ‒ прямая дискриминация. Например, если система распознавания языка жестов плохо распознает жесты, выполняемые человеком с инвалидностью, то это может затруднить его общение с окружающими и ограничить его возможности в сфере образования и трудоустройства.

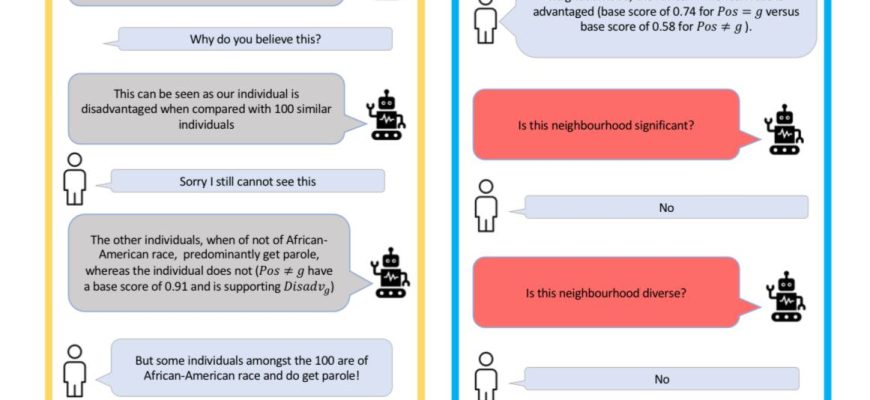

В более серьезных случаях предвзятость в системах распознавания жестов может приводить к несправедливым решениям в сфере правосудия, здравоохранения и социального обеспечения. Например, если система, используемая для оценки рисков в уголовном судопроизводстве, предвзято относится к людям определенной расы или пола, то это может привести к тому, что эти люди будут чаще подвергаться арестам и более длительным срокам заключения.

Важно понимать, что предвзятость в системах ИИ не является случайностью. Это результат недостаточного внимания к вопросам этики и справедливости на этапе разработки и обучения алгоритмов. Поэтому, чтобы избежать дискриминации в технологиях будущего, необходимо принимать активные меры по борьбе с предвзятостью на всех этапах жизненного цикла ИИ.

"Технологии должны служить всем людям, а не только избранным. Мы должны стремиться к созданию ИИ, который будет справедливым, прозрачным и ответственным."

— Сатья Наделла, генеральный директор Microsoft

Как бороться с предвзятостью: Практические рекомендации

Борьба с предвзятостью в системах распознавания жестов ⎯ это сложная задача, требующая комплексного подхода. Вот несколько практических рекомендаций, которые мы считаем наиболее важными:

- Собирайте разнообразные данные. Убедитесь, что обучающие данные для вашей системы распознавания жестов содержат достаточное количество примеров жестов, выполняемых людьми разных рас, полов, возрастов, физических особенностей и культурных традиций.

- Проверяйте данные на наличие ошибок и предвзятости. Тщательно проверяйте обучающие данные на наличие ошибок в разметке жестов и предвзятых представлений о различных группах людей.

- Используйте алгоритмы, устойчивые к предвзятости. Выбирайте алгоритмы, которые менее склонны к "запоминанию" стереотипов и более способны к обобщению.

- Оценивайте систему на различных группах людей. Проводите тестирование системы на различных группах людей, чтобы выявить возможные проявления предвзятости.

- Сделайте систему прозрачной и понятной. Объясняйте, как работает ваша система и какие факторы влияют на ее решения.

- Привлекайте экспертов по этике и социальной справедливости. Консультируйтесь с экспертами по этике и социальной справедливости на всех этапах разработки и внедрения системы.

- Будьте готовы к изменениям. Постоянно отслеживайте работу системы и вносите необходимые изменения, чтобы устранить выявленные проявления предвзятости.

Эти рекомендации помогут вам создать системы распознавания жестов, которые будут справедливыми и полезными для всех людей.

Инструменты и ресурсы для борьбы с предвзятостью

К счастью, существует множество инструментов и ресурсов, которые могут помочь в борьбе с предвзятостью в системах ИИ. Вот некоторые из них:

- Библиотеки для анализа данных. Pandas, NumPy и Scikit-learn ⎯ это мощные библиотеки Python, которые позволяют анализировать данные на наличие предвзятости и ошибок.

- Инструменты для оценки справедливости. AI Fairness 360 и Fairlearn ⎯ это инструменты, разработанные IBM и Microsoft соответственно, которые позволяют оценивать справедливость моделей машинного обучения.

- Наборы данных с информацией о предвзятости. Существуют наборы данных, содержащие информацию о предвзятости в различных сферах, которые можно использовать для обучения и тестирования моделей машинного обучения.

- Рекомендации и стандарты. Существуют рекомендации и стандарты, разработанные различными организациями, которые помогают разработчикам создавать справедливые и ответственные системы ИИ.

Использование этих инструментов и ресурсов поможет вам сделать вашу работу более эффективной и избежать ошибок, связанных с предвзятостью.

Будущее распознавания жестов: К справедливому и инклюзивному ИИ

Мы верим, что будущее распознавания жестов ⎯ за справедливым и инклюзивным ИИ. Технологии должны служить всем людям, независимо от их расы, пола, возраста, физических особенностей и культурных традиций. Чтобы достичь этой цели, необходимо прилагать постоянные усилия по борьбе с предвзятостью на всех этапах жизненного цикла ИИ. Это требует не только технических знаний, но и глубокого понимания этических и социальных проблем.

Мы надеемся, что эта статья поможет вам лучше понять проблему предвзятости в системах распознавания жестов и принять меры по ее устранению. Вместе мы можем создать технологии, которые будут делать мир лучше для всех.

Подробнее

| Распознавание жестов для людей с инвалидностью | Предвзятость в алгоритмах машинного обучения | Этика искусственного интеллекта | Анализ данных на предвзятость | Инклюзивный дизайн в технологиях |

|---|---|---|---|---|

| Обучение ИИ на разнообразных данных | Справедливость в машинном обучении | Тестирование систем распознавания жестов | Последствия предвзятости в ИИ | Прозрачность в алгоритмах ИИ |