- ИИ: Зеркало наших предрассудков? Этика, Раса и Справедливость в Мире Алгоритмов

- Эволюция ИИ и невидимые предубеждения

- Источники предвзятости в данных

- Примеры расовой предвзятости в ИИ

- Влияние на различные сферы жизни

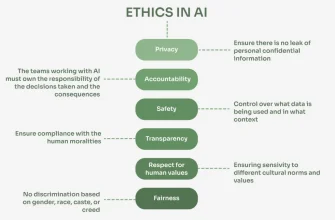

- Что делать? Пути к справедливому ИИ

- Роль образования и этического кодекса

- Будущее ИИ: Надежда на справедливость

- Призыв к действию

ИИ: Зеркало наших предрассудков? Этика, Раса и Справедливость в Мире Алгоритмов

Приветствую, друзья! Сегодня мы погрузимся в тему, которая касается каждого, кто задумывается о будущем технологий и о том, как они формируют наше общество. Речь пойдет об этике искусственного интеллекта (ИИ) и ее неразрывной связи с вопросами расовой справедливости. Мы все чаще полагаемся на алгоритмы, чтобы принимать решения – от кредитных рейтингов до найма на работу. Но что, если эти алгоритмы несут в себе скрытые предрассудки, отражающие исторические и современные формы дискриминации? Давайте разбираться вместе.

Эволюция ИИ и невидимые предубеждения

Искусственный интеллект развивается с головокружительной скоростью. То, что вчера казалось научной фантастикой, сегодня – обыденность. Однако, вместе с технологическим прогрессом возникают и серьезные вопросы. ИИ обучается на данных, а данные, как известно, не всегда объективны. Они могут содержать в себе отражение социальных, экономических и расовых неравенств. Если мы не будем внимательны, ИИ может не только воспроизвести эти неравенства, но и усилить их.

Представьте себе систему распознавания лиц, которая лучше распознает лица людей европеоидной расы, чем африканской. Или алгоритм, который автоматически предлагает более низкие кредитные лимиты людям, живущим в районах с преобладающим афроамериканским населением. Это не гипотетические сценарии, а реальные примеры, которые уже происходили и продолжают происходить. Почему так получается?

Источники предвзятости в данных

Основная проблема заключается в данных, на которых обучаются алгоритмы. Эти данные могут быть предвзятыми по нескольким причинам:

- Исторические данные: Они могут отражать дискриминационные практики прошлого. Например, данные о найме на работу, собранные в период, когда определенные группы населения были ограничены в доступе к определенным профессиям.

- Неполные данные: Если в обучающем наборе недостаточно данных о представителях определенных расовых групп, алгоритм может хуже распознавать их особенности и делать ошибки.

- Субъективные оценки: Даже если данные кажутся объективными, они могут содержать субъективные оценки, отражающие предрассудки тех, кто их собирал или анализировал.

Все эти факторы приводят к тому, что ИИ может непреднамеренно воспроизводить и усиливать существующие неравенства.

Примеры расовой предвзятости в ИИ

К сожалению, примеров расовой предвзятости в ИИ предостаточно. Вот лишь некоторые из них:

- Системы распознавания лиц: Как уже упоминалось, многие системы распознавания лиц хуже распознают лица людей с темной кожей. Это может привести к ошибочным арестам и другим негативным последствиям.

- Алгоритмы оценки рисков в уголовном правосудии: Эти алгоритмы используются для оценки вероятности того, что обвиняемый совершит новое преступление. Исследования показали, что они чаще ошибочно оценивают афроамериканцев как более склонных к совершению преступлений, чем белых.

- Инструменты найма на работу: Некоторые инструменты, используемые для автоматического отбора резюме, могут отдавать предпочтение кандидатам с именами, которые ассоциируются с определенными расовыми группами.

Эти примеры демонстрируют, что расовая предвзятость в ИИ – это не просто теоретическая проблема, а реальная угроза для справедливости и равенства.

Влияние на различные сферы жизни

Последствия расовой предвзятости в ИИ могут быть далеко идущими. Они затрагивают различные сферы жизни, включая:

| Сфера | Пример влияния |

|---|---|

| Здравоохранение | Алгоритмы, определяющие приоритетность медицинской помощи, могут недооценивать потребности пациентов из определенных расовых групп. |

| Образование | Автоматизированные системы оценивания могут предвзято относиться к работам студентов из определенных расовых групп. |

| Финансы | Алгоритмы, определяющие кредитные рейтинги, могут дискриминировать людей, живущих в районах с преобладающим небелым населением. |

Что делать? Пути к справедливому ИИ

К счастью, осознание проблемы расовой предвзятости в ИИ растет. Все больше исследователей, разработчиков и политиков работают над тем, чтобы создать более справедливые и этичные алгоритмы. Что же мы можем сделать, чтобы внести свой вклад?

"Технологии не нейтральны. Они отражают ценности тех, кто их создает." – Мелани Субба.

Вот несколько важных шагов:

- Собирать более разнообразные и репрезентативные данные: Необходимо приложить усилия для сбора данных, которые отражают разнообразие населения. Это поможет снизить вероятность предвзятости в алгоритмах.

- Разрабатывать методы обнаружения и исправления предвзятости: Существуют различные методы, которые позволяют обнаруживать и исправлять предвзятость в данных и алгоритмах. Необходимо активно использовать эти методы.

- Обеспечивать прозрачность и подотчетность: Важно, чтобы алгоритмы были прозрачными и понятными для тех, кто их использует. Также необходимо установить механизмы подотчетности, чтобы можно было привлекать к ответственности тех, кто создает предвзятые алгоритмы.

- Привлекать к разработке ИИ представителей различных расовых групп: Чем более разнообразной будет команда разработчиков, тем меньше вероятность того, что в алгоритмы попадут неосознанные предрассудки.

- Повышать осведомленность: Необходимо рассказывать о проблеме расовой предвзятости в ИИ как можно большему числу людей. Чем больше людей будет знать об этой проблеме, тем больше шансов на то, что мы сможем ее решить.

Роль образования и этического кодекса

Образование играет ключевую роль в формировании этичного подхода к разработке ИИ. Необходимо обучать студентов и специалистов в области информационных технологий основам этики и социальной ответственности. Также важно разрабатывать и внедрять этические кодексы, которые будут регулировать разработку и использование ИИ.

Кроме того, необходимо поддерживать исследования, направленные на разработку более справедливых и этичных алгоритмов. Эти исследования должны быть направлены на решение конкретных проблем, связанных с расовой предвзятостью в ИИ.

Будущее ИИ: Надежда на справедливость

Хотя проблема расовой предвзятости в ИИ – это серьезный вызов, у нас есть все возможности для того, чтобы ее преодолеть. Осознание проблемы, разработка новых методов обнаружения и исправления предвзятости, а также усилия по повышению осведомленности – все это дает надежду на то, что будущее ИИ будет более справедливым и равноправным.

Мы верим, что ИИ может стать мощным инструментом для решения социальных проблем, в т.ч. и для борьбы с расовой дискриминацией. Но для этого необходимо приложить усилия для того, чтобы ИИ был разработан и использовался этично и ответственно.

Призыв к действию

Каждый из нас может внести свой вклад в создание более справедливого ИИ. Мы можем поддерживать организации, которые работают над этой проблемой, мы можем делиться информацией об этике ИИ в социальных сетях, и мы можем требовать от компаний, которые используют ИИ, чтобы они делали это ответственно и этично.

Вместе мы можем создать будущее, в котором ИИ будет служить интересам всего человечества, а не только избранных.

Подробнее

| LSI Запрос 1 | LSI Запрос 2 | LSI Запрос 3 | LSI Запрос 4 | LSI Запрос 5 |

|---|---|---|---|---|

| Предвзятость в машинном обучении | Этика искусственного интеллекта | Расовая дискриминация в алгоритмах | Справедливый ИИ | Влияние ИИ на расовые меньшинства |

| LSI Запрос 6 | LSI Запрос 7 | LSI Запрос 8 | LSI Запрос 9 | LSI Запрос 10 |

| Алгоритмическая справедливость | Обнаружение предвзятости в ИИ | Этические принципы ИИ | Равенство и искусственный интеллект | Прозрачность алгоритмов |