- Искусственный интеллект: Государство на страже будущего или тормоз прогресса?

- Почему контроль за ИИ необходим?

- Какие формы контроля могут быть эффективными?

- Законодательное регулирование

- Стандарты и сертификация

- Саморегулирование отрасли

- Личный опыт и размышления

- Международное сотрудничество

- Риски чрезмерного контроля

Искусственный интеллект: Государство на страже будущего или тормоз прогресса?

Приветствую, друзья! Сегодня мы погрузимся в одну из самых захватывающих и неоднозначных тем современности – роль государства в контроле за искусственным интеллектом (ИИ). Мы, как активные пользователи и наблюдатели за развитием технологий, не можем оставаться в стороне от этого вопроса. Ведь от того, как будет регулироваться ИИ, зависит наше будущее, будущее наших детей и всей цивилизации в целом.

Мы постараемся рассмотреть эту проблему с разных сторон, взвесить все "за" и "против", и, конечно же, поделиться своим личным опытом и соображениями. Приготовьтесь к глубокому погружению в мир алгоритмов, этики и государственной политики!

Почему контроль за ИИ необходим?

Начнем с главного: почему вообще возникла необходимость в контроле за ИИ? Ведь, казалось бы, это всего лишь инструмент, пусть и очень мощный. Но, как показывает история, любой мощный инструмент в руках человека может быть использован как во благо, так и во вред.

ИИ уже сейчас влияет на многие аспекты нашей жизни: от рекомендаций в онлайн-магазинах до систем распознавания лиц и автономных транспортных средств. И чем дальше, тем больше будет его влияние. Поэтому, чтобы избежать негативных последствий, необходимо установить определенные правила и границы.

- Безопасность: ИИ может быть использован для создания автономного оружия или систем слежки, что представляет серьезную угрозу для безопасности людей и государств.

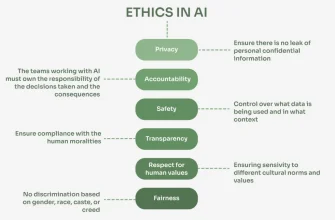

- Этика: Алгоритмы ИИ могут быть предвзятыми и дискриминировать определенные группы населения.

- Экономика: Автоматизация, основанная на ИИ, может привести к массовой потере рабочих мест и увеличению социального неравенства.

- Конфиденциальность: Сбор и анализ больших данных, необходимых для обучения ИИ, может нарушать право на частную жизнь.

Все эти факторы делают контроль за ИИ не просто желательным, а необходимым условием для его безопасного и устойчивого развития.

Какие формы контроля могут быть эффективными?

Теперь давайте поговорим о том, какие формы контроля за ИИ могут быть наиболее эффективными. Здесь нет универсального решения, и каждый подход имеет свои преимущества и недостатки.

Законодательное регулирование

Первый и самый очевидный способ – это принятие законов и нормативных актов, регулирующих разработку и использование ИИ. Такие законы могут устанавливать требования к безопасности, этичности и прозрачности алгоритмов, а также определять ответственность за нарушение этих требований.

Например, Европейский Союз активно работает над созданием всеобъемлющего законодательства в области ИИ, которое будет охватывать широкий спектр вопросов, от защиты персональных данных до предотвращения дискриминации. В идеале, такое законодательство должно быть гибким и адаптируемым к быстро меняющимся технологиям, чтобы не тормозить инновации.

Стандарты и сертификация

Другой подход – это разработка стандартов и систем сертификации для ИИ-систем. Эти стандарты могут определять минимальные требования к качеству, безопасности и этичности алгоритмов, а сертификация может подтверждать соответствие этим требованиям.

Например, существуют стандарты ISO, которые могут быть адаптированы для применения к ИИ. Сертификация, в свою очередь, может проводиться независимыми организациями, что повышает доверие к результатам.

Саморегулирование отрасли

Третий подход – это саморегулирование отрасли, когда компании, занимающиеся разработкой и использованием ИИ, сами устанавливают правила и нормы поведения. Это может быть оформлено в виде кодексов этики, соглашений о сотрудничестве или отраслевых стандартов.

Преимущество этого подхода в том, что он позволяет учитывать специфику каждой отрасли и быстро адаптироватся к новым технологиям. Однако, эффективность саморегулирования зависит от готовности компаний соблюдать установленные правила и от наличия механизмов контроля и санкций за их нарушение.

"Искусственный интеллект – это как огонь. Он может согреть дом или сжечь его дотла."

– Макс Тегмарк, профессор Массачусетского технологического института

Личный опыт и размышления

В нашей практике, мы часто сталкиваемся с ситуациями, когда ИИ используется не совсем этично или безопасно. Например, мы видели, как алгоритмы рекомендаций в социальных сетях создают "пузыри фильтров", в которых люди видят только ту информацию, которая подтверждает их убеждения. Это приводит к поляризации общества и затрудняет диалог между разными группами.

Мы также сталкивались с ситуациями, когда ИИ использовался для манипулирования людьми, например, в политической рекламе. Алгоритмы анализируют данные пользователей и показывают им только ту информацию, которая может повлиять на их мнение в нужном направлении. Это подрывает доверие к информации и демократическим институтам.

Поэтому мы считаем, что контроль за ИИ необходим, но он должен быть разумным и сбалансированным. Нельзя допустить, чтобы он задушил инновации и прогресс. Необходимо найти золотую середину между свободой развития и защитой прав и интересов людей.

Международное сотрудничество

Искусственный интеллект – это глобальная технология, которая не знает границ. Поэтому и контроль за ней должен быть международным. Необходимо сотрудничество между странами в разработке общих стандартов, правил и норм поведения в области ИИ.

Например, Организация Объединенных Наций (ООН) может играть важную роль в координации усилий разных стран по контролю за ИИ. Также важно сотрудничество между научными сообществами, бизнесом и гражданским обществом.

Риски чрезмерного контроля

Нельзя забывать и о рисках чрезмерного контроля. Слишком жесткое регулирование может задушить инновации, привести к утечке мозгов и отставанию в развитии технологий. Поэтому необходимо найти баланс между контролем и свободой.

Государство должно создавать благоприятную среду для развития ИИ, поддерживать исследования и разработки, стимулировать инновации и привлекать инвестиции. Только в этом случае мы сможем использовать потенциал ИИ во благо человечества.

Мы надеемся, что наша статья помогла вам лучше понять эту проблему и сформировать свое мнение. Будем рады услышать ваши комментарии и предложения!

Подробнее

| Этика искусственного интеллекта | Регулирование ИИ | Безопасность ИИ | Влияние ИИ на экономику | Государственная политика в области ИИ |

|---|---|---|---|---|

| Автономное оружие | Предвзятость алгоритмов | Защита персональных данных | Международное сотрудничество в области ИИ | Риски искусственного интеллекта |