- Этические дилеммы ИИ: Как мы разрабатываем лекарства, не теряя человечность

- Этические вызовы в доклинической разработке лекарств с использованием ИИ

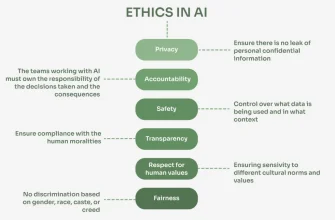

- Предвзятость данных и дискриминация

- Прозрачность и объяснимость алгоритмов

- Ответственность за ошибки ИИ

- Практические шаги для этичной разработки лекарств с использованием ИИ

- Примеры этических дилемм и их решения

Этические дилеммы ИИ: Как мы разрабатываем лекарства, не теряя человечность

В современном мире искусственный интеллект (ИИ) проникает во все сферы нашей жизни, и разработка лекарств не является исключением․ Мы, как исследователи и разработчики, видим огромный потенциал в использовании ИИ для ускорения процесса создания новых лекарств, повышения их эффективности и снижения затрат․ Но вместе с тем, мы сталкиваемся с серьезными этическими вопросами, которые требуют внимательного рассмотрения и ответственного подхода․

Представьте себе: алгоритмы ИИ анализируют огромные массивы данных, чтобы выявить потенциальные мишени для лекарств, предсказывают структуру молекул с заданными свойствами и даже проводят виртуальные клинические испытания․ Все это звучит как научная фантастика, но уже сегодня является реальностью․ Однако, кто несет ответственность за ошибки, допущенные ИИ? Как обеспечить справедливость и прозрачность в процессе принятия решений, основанных на алгоритмах? И как защитить конфиденциальность данных пациентов, используемых для обучения ИИ?

Этические вызовы в доклинической разработке лекарств с использованием ИИ

Доклиническая разработка лекарств – это сложный и многоэтапный процесс, который включает в себя идентификацию мишени, разработку и оптимизацию лекарственного кандидата, а также оценку его безопасности и эффективности на клеточных культурах и животных моделях․ ИИ может значительно ускорить и упростить каждый из этих этапов, но при этом возникают специфические этические вопросы․

Предвзятость данных и дискриминация

Одной из главных проблем является предвзятость данных, на которых обучаются алгоритмы ИИ․ Если данные, используемые для обучения, не репрезентативны для всего населения, то ИИ может выдавать результаты, которые дискриминируют определенные группы людей․ Например, если данные о генетической предрасположенности к определенному заболеванию собирались преимущественно у представителей европейской расы, то лекарство, разработанное на основе этих данных, может быть менее эффективным или даже опасным для людей другой расы․

Мы должны осознавать, что данные, которые мы используем для обучения ИИ, являются отражением нашего общества, со всеми его предрассудками и неравенствами․ Поэтому, мы обязаны тщательно анализировать данные на предмет предвзятости и принимать меры для ее устранения․ Это может включать в себя сбор данных из разных источников, использование методов балансировки данных и разработку алгоритмов, устойчивых к предвзятости․

Прозрачность и объяснимость алгоритмов

Многие алгоритмы ИИ, особенно глубокое обучение, работают как "черный ящик"․ Мы можем видеть входные данные и выходные результаты, но не понимаем, как именно алгоритм пришел к этому результату․ Это создает проблему прозрачности и объяснимости․ Если мы не можем объяснить, почему ИИ рекомендовал определенный лекарственный кандидат, то как мы можем быть уверены в его безопасности и эффективности? Как мы можем убедить регуляторные органы и пациентов в том, что лекарство было разработано этичным и ответственным образом?

Для решения этой проблемы необходимо разрабатывать и использовать алгоритмы ИИ, которые являются более прозрачными и объяснимыми․ Это может включать в себя использование методов визуализации, которые позволяют нам видеть, как алгоритм обрабатывает данные, а также разработку алгоритмов, которые предоставляют объяснения своих решений․ Кроме того, необходимо обучать специалистов, которые смогут интерпретировать результаты, полученные с помощью ИИ, и оценивать их надежность․

Ответственность за ошибки ИИ

Что произойдет, если ИИ допустит ошибку и предложит лекарственный кандидат, который окажется токсичным или неэффективным? Кто будет нести ответственность за последствия? Разработчики алгоритма? Исследователи, которые использовали ИИ? Фармацевтическая компания, которая выпустила лекарство на рынок? Ответ на этот вопрос не является простым и требует тщательного юридического и этического анализа․

Мы считаем, что ответственность должна быть разделена между всеми участниками процесса разработки лекарств․ Разработчики алгоритмов должны нести ответственность за качество и надежность своих алгоритмов․ Исследователи должны нести ответственность за правильное использование ИИ и за проверку результатов, полученных с его помощью․ Фармацевтические компании должны нести ответственность за безопасность и эффективность лекарств, которые они выпускают на рынок․ Кроме того, необходимо создать систему страхования ответственности, которая позволит компенсировать ущерб, причиненный ошибками ИИ․

"Технологический прогресс неизбежен, но этические принципы должны направлять его развитие․"

― Стивен Хокинг

Практические шаги для этичной разработки лекарств с использованием ИИ

Недостаточно просто осознавать этические проблемы, связанные с использованием ИИ в разработке лекарств․ Необходимо предпринимать конкретные шаги для их решения․ Мы предлагаем следующие практические рекомендации:

- Разработка этических кодексов и стандартов․ Необходимо разработать этические кодексы и стандарты, которые будут регулировать использование ИИ в разработке лекарств․ Эти кодексы должны охватывать вопросы предвзятости данных, прозрачности алгоритмов, ответственности за ошибки и защиты конфиденциальности данных․

- Обучение и повышение квалификации специалистов․ Необходимо обучать и повышать квалификацию специалистов в области ИИ, этики и разработки лекарств․ Эти специалисты должны обладать знаниями и навыками, необходимыми для решения этических проблем, связанных с использованием ИИ․

- Создание механизмов надзора и контроля․ Необходимо создать механизмы надзора и контроля, которые будут обеспечивать соблюдение этических кодексов и стандартов․ Эти механизмы должны включать в себя проведение этической экспертизы проектов, использующих ИИ, а также расследование нарушений этических норм․

- Вовлечение общественности в обсуждение этических вопросов․ Необходимо вовлекать общественность в обсуждение этических вопросов, связанных с использованием ИИ в разработке лекарств․ Это позволит повысить осведомленность общественности о потенциальных рисках и выгодах ИИ, а также сформировать общественное мнение о том, как следует использовать ИИ в этой области․

Примеры этических дилемм и их решения

Давайте рассмотрим несколько конкретных примеров этических дилемм, которые могут возникнуть при использовании ИИ в доклинической разработке лекарств, и предложим возможные решения:

- Дилемма: ИИ выявил, что лекарственный кандидат может быть эффективным только для определенной генетической группы․ Стоит ли разрабатывать лекарство, зная, что оно не будет доступно для всех пациентов?

Решение: Необходимо провести дополнительные исследования, чтобы определить, можно ли модифицировать лекарство, чтобы оно стало эффективным для более широкой группы пациентов․ Если это невозможно, то необходимо честно и открыто сообщить об этом пациентам и регуляторным органам․ Кроме того, необходимо разрабатывать лекарства, которые будут эффективны для других генетических групп․ - Дилемма: ИИ предложил использовать данные пациентов без их согласия для обучения алгоритма․ Стоит ли это делать, чтобы ускорить разработку лекарства?

Решение: Использование данных пациентов без их согласия является недопустимым․ Необходимо получать информированное согласие пациентов на использование их данных для научных исследований․ Кроме того, необходимо использовать методы анонимизации данных, чтобы защитить конфиденциальность пациентов․ - Дилемма: ИИ допустил ошибку и предложил лекарственный кандидат, который оказался токсичным в ходе доклинических испытаний․ Кто должен нести ответственность?

Решение: Ответственность должна быть разделена между разработчиками алгоритма, исследователями, которые использовали ИИ, и фармацевтической компанией․ Необходимо провести расследование, чтобы определить причину ошибки и принять меры для ее предотвращения в будущем․ Кроме того, необходимо создать систему страхования ответственности, которая позволит компенсировать ущерб, причиненный ошибками ИИ․

Использование ИИ в разработке лекарств открывает огромные возможности для создания новых, более эффективных и безопасных лекарств․ Однако, необходимо помнить об этических вопросах, которые возникают в связи с этим․ Мы должны разрабатывать и использовать ИИ этичным и ответственным образом, чтобы обеспечить, чтобы его преимущества были доступны для всех, а риски были сведены к минимуму․ Только тогда мы сможем реализовать весь потенциал ИИ для улучшения здоровья и благополучия людей․

Мы верим, что будущее разработки лекарств тесно связано с ИИ, но только при условии, что мы будем уделять должное внимание этическим аспектам․ Нам необходимо создать прочную этическую основу, которая позволит нам использовать ИИ во благо человечества, не теряя при этом нашу человечность․

Подробнее

| LSI Запрос | LSI Запрос | LSI Запрос | LSI Запрос | LSI Запрос |

|---|---|---|---|---|

| Этика ИИ в медицине | ИИ в фармацевтике | Этические риски ИИ | Ответственность ИИ | Прозрачность алгоритмов |

| Предвзятость данных в ИИ | Использование ИИ в доклинике | Этические стандарты ИИ | Регулирование ИИ в медицине | Безопасность лекарств и ИИ |