- Этические дилеммы в разработке ИИ для дронов: Когда технология встречается с моралью

- Автономность и ответственность

- Конфиденциальность и наблюдение

- Предвзятость алгоритмов и дискриминация

- Военное применение и летальное оружие

- Применение в правоохранительных органах

- Будущее ИИ для дронов: Навигация по этическому ландшафту

Этические дилеммы в разработке ИИ для дронов: Когда технология встречается с моралью

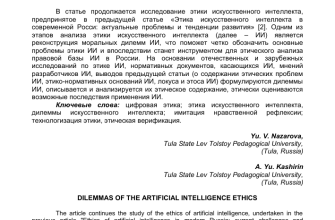

Мир вокруг нас стремительно меняется, и одним из самых ярких проявлений этого является развитие искусственного интеллекта (ИИ) и его интеграция в беспилотные летательные аппараты, или дроны. Мы, как свидетели и участники этого процесса, не можем не задаваться вопросом: а все ли мы делаем правильно? Какие этические вызовы встают перед нами, когда мы наделяем машины способностью принимать решения, особенно в ситуациях, где на кону стоят человеческие жизни?

В этой статье мы погрузимся в сложный и многогранный мир этических дилемм, возникающих при разработке ИИ для дронов. Мы рассмотрим различные аспекты этой проблемы, от вопросов ответственности и подотчетности до проблем конфиденциальности и предвзятости алгоритмов. Наша цель – не дать однозначные ответы, а скорее стимулировать дискуссию и помочь нам всем лучше понять, какие вопросы необходимо задавать себе и другим, чтобы обеспечить ответственное и этичное развитие этой многообещающей, но потенциально опасной технологии.

Автономность и ответственность

Одна из ключевых этических проблем, связанных с ИИ для дронов, – это вопрос автономности. Насколько мы готовы доверить машинам принятие решений, особенно в ситуациях, требующих моральной оценки? Если дрон, управляемый ИИ, совершает ошибку, кто несет ответственность? Разработчик? Оператор? Или сам ИИ?

Представьте себе дрон, используемый для наблюдения за территорией. Он запрограммирован на автоматическое обнаружение и отслеживание подозрительных объектов. Но что, если дрон ошибочно идентифицирует обычного прохожего как угрозу и предпринимает действия, приводящие к трагедии? Кто будет виноват? Сложный вопрос, не правда ли? Нам нужно четко определить границы автономности ИИ и установить механизмы, обеспечивающие подотчетность за его действия.

Конфиденциальность и наблюдение

Дроны, оснащенные ИИ, обладают беспрецедентными возможностями для сбора данных и наблюдения. Они могут записывать видео, собирать информацию о местоположении и даже анализировать поведение людей. Это поднимает серьезные вопросы о конфиденциальности и праве на частную жизнь.

Мы должны разработать строгие правила и ограничения на использование дронов для наблюдения. Необходимо обеспечить прозрачность в отношении того, какие данные собираются, как они используются и кто имеет к ним доступ. Важно найти баланс между необходимостью использования дронов для обеспечения безопасности и защиты прав граждан на частную жизнь.

Предвзятость алгоритмов и дискриминация

ИИ, как и любая другая технология, не свободен от предвзятости. Алгоритмы машинного обучения обучаются на данных, и если эти данные содержат предвзятости, то и ИИ будет их воспроизводить. Это может привести к дискриминации и несправедливому отношению к определенным группам людей.

Например, если ИИ для дрона, используемого для поиска пропавших людей, обучался на данных, в которых преобладают изображения людей определенной расы или пола, он может хуже обнаруживать людей других рас или полов. Мы должны прилагать усилия для выявления и устранения предвзятости в алгоритмах ИИ. Необходимо использовать разнообразные и репрезентативные наборы данных для обучения и проводить тщательное тестирование, чтобы убедиться, что ИИ не дискриминирует.

"Технологический прогресс подобен топору в руках патологического преступника."

Военное применение и летальное оружие

Одним из самых спорных аспектов разработки ИИ для дронов является их военное применение. Автономные дроны-убийцы, способные самостоятельно выбирать и поражать цели, – это реальность, вызывающая серьезные опасения. Многие эксперты и организации призывают к запрету разработки и использования такого оружия.

Мы считаем, что вопрос о военном применении ИИ для дронов требует широкой общественной дискуссии и международного регулирования. Необходимо установить четкие этические и юридические рамки, чтобы предотвратить злоупотребление этой технологией и избежать нежелательных последствий.

Применение в правоохранительных органах

Помимо военного применения, дроны с ИИ все чаще используются правоохранительными органами для наблюдения, патрулирования и реагирования на чрезвычайные ситуации. Это может повысить эффективность работы полиции, но также создает риски нарушения гражданских свобод.

Важно, чтобы использование дронов правоохранительными органами было прозрачным и подотчетным. Необходимо установить четкие правила и процедуры, регулирующие их применение, и обеспечить защиту прав граждан на частную жизнь и свободу передвижения.

Будущее ИИ для дронов: Навигация по этическому ландшафту

Разработка ИИ для дронов – это сложный и многогранный процесс, требующий учета множества этических факторов. Мы должны подходить к этой задаче с осторожностью и ответственностью, стремясь к тому, чтобы эта технология приносила пользу обществу, а не причиняла вред.

Нам необходимо продолжать общественную дискуссию об этических аспектах ИИ для дронов, привлекать к ней экспертов из разных областей и учитывать мнение широкой общественности. Только так мы сможем разработать эффективные правила и стандарты, обеспечивающие ответственное и этичное развитие этой технологии.

Мы верим, что будущее ИИ для дронов может быть светлым, если мы будем помнить о нашей ответственности и стремиться к тому, чтобы эта технология служила на благо человечества. Это требует постоянного внимания к этическим вопросам, открытости к новым идеям и готовности к адаптации к меняющимся обстоятельствам.

Подробнее

| Этика ИИ дронов | Автономные дроны | Конфиденциальность дронов | Предвзятость алгоритмов | Военные дроны |

|---|---|---|---|---|

| Дроны правоохранительных органов | Ответственность ИИ | Регулирование дронов | Этические дилеммы ИИ | ИИ и мораль |