- Этические дилеммы в разработке ИИ для дронов: Наш опыт балансирования на грани

- Первые шаги: Осознание масштаба проблемы

- Ключевые этические вопросы

- Приватность: Баланс между пользой и вторжением

- Безопасность: Предотвращение несчастных случаев и злоупотреблений

- Ответственность: Кто виноват, если что-то пойдет не так?

- Прозрачность: Открытие "черного ящика"

- Справедливость: Избежание предвзятости

- Наши уроки и рекомендации

Этические дилеммы в разработке ИИ для дронов: Наш опыт балансирования на грани

Мы, как команда разработчиков, столкнулись с захватывающим и одновременно тревожным миром создания искусственного интеллекта для дронов. Это область, где технологии развиваются стремительно, но этические вопросы часто остаются позади. Наш путь был полон неожиданных поворотов, сложных решений и постоянного переосмысления нашей ответственности. Мы хотим поделиться своим опытом, чтобы другие разработчики и пользователи могли лучше понимать и решать этические вызовы, возникающие при создании автономных систем.

Дроны с ИИ уже не просто игрушки или инструменты для фотосъемки. Они становятся глазами и ушами в зонах бедствий, доставляют жизненно важные медикаменты, инспектируют инфраструктуру и даже патрулируют границы. Но с каждой новой возможностью возникают новые риски. Кто несет ответственность, если дрон совершает ошибку? Как защитить частную жизнь людей от всевидящего ока беспилотника? Как предотвратить использование этих технологий во вред?

Первые шаги: Осознание масштаба проблемы

Когда мы только начинали работать над проектом, мы были сосредоточены на технических аспектах: улучшение навигации, повышение точности распознавания объектов, оптимизация энергопотребления. Этика казалась чем-то второстепенным, чем-то, что можно будет решить позже. Но вскоре мы поняли, что это огромная ошибка. Каждое наше решение, каждый алгоритм, который мы создавали, имел потенциальные этические последствия.

Например, мы разрабатывали систему автоматического распознавания людей для поисково-спасательных операций. Звучит замечательно, правда? Но что, если эта система будет использоваться для слежки за гражданами? Что, если она будет ошибочно идентифицировать людей и приводить к необоснованным подозрениям? Мы поняли, что должны учитывать эти риски с самого начала.

Ключевые этические вопросы

В процессе работы мы выделили несколько ключевых этических вопросов, которые должны учитывать все разработчики ИИ для дронов:

- Приватность: Как обеспечить, чтобы дроны не нарушали право людей на частную жизнь?

- Безопасность: Как предотвратить несчастные случаи и злонамеренное использование дронов?

- Ответственность: Кто несет ответственность за действия дрона, особенно если он действует автономно?

- Прозрачность: Как сделать алгоритмы ИИ более понятными и предсказуемыми?

- Справедливость: Как избежать предвзятости в алгоритмах и обеспечить равное отношение ко всем людям?

Приватность: Баланс между пользой и вторжением

Оснащенные камерами высокого разрешения и сложными алгоритмами распознавания, дроны могут собирать огромные объемы данных о людях и их деятельности. Как мы можем использовать эти данные для блага общества, не нарушая при этом фундаментальное право на частную жизнь? Мы пришли к нескольким решениям:

- Минимизация данных: Собирать только те данные, которые действительно необходимы для выполнения задачи.

- Анонимизация данных: Удалять или шифровать личную информацию, чтобы ее нельзя было связать с конкретными людьми.

- Прозрачность: Информировать людей о том, какие данные собираются и как они используются.

- Контроль пользователей: Предоставлять людям возможность контролировать, какие данные о них собираются и как они используются.

Мы также экспериментировали с технологиями "дифференциальной приватности", которые позволяют анализировать данные, не раскрывая личную информацию отдельных людей. Это сложная область, но она имеет огромный потенциал для защиты приватности в мире, где все больше и больше данных собирается и анализируется.

Безопасность: Предотвращение несчастных случаев и злоупотреблений

Дроны могут быть опасными, если они падают с неба, сталкиваются с препятствиями или используются для перевозки опасных грузов. Мы должны сделать все возможное, чтобы предотвратить эти риски. Это включает в себя:

- Надежные системы навигации и управления: Дроны должны быть способны безопасно перемещаться в различных условиях и избегать столкновений.

- Системы резервирования: Если одна система выходит из строя, другая должна взять на себя управление.

- Ограничения по высоте и скорости: Дроны не должны летать слишком высоко или слишком быстро, чтобы избежать несчастных случаев.

- Геофенсинг: Дроны должны быть запрограммированы на то, чтобы не летать в запрещенных зонах, таких как аэропорты и военные объекты.

Кроме того, мы должны учитывать возможность злонамеренного использования дронов. Они могут быть использованы для шпионажа, доставки наркотиков или даже для совершения терактов. Мы должны разрабатывать системы, которые могут обнаруживать и предотвращать такие атаки. Это включает в себя:

- Системы обнаружения дронов: Обнаруживать несанкционированные дроны в небе.

- Системы перехвата дронов: Перехватывать и нейтрализовать опасные дроны.

- Кибербезопасность: Защищать дроны от хакерских атак.

"Технологии не являются ни хорошими, ни плохими; ни нейтральными." ー Melvin Kranzberg

Ответственность: Кто виноват, если что-то пойдет не так?

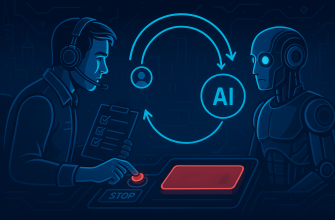

Один из самых сложных этических вопросов, связанных с ИИ, заключается в том, кто несет ответственность за действия автономной системы. Если дрон совершает ошибку, кто виноват? Разработчик? Оператор? Производитель? Или сам дрон?

Мы считаем, что ответственность должна быть разделена между всеми участниками процесса. Разработчики должны создавать безопасные и надежные системы. Операторы должны использовать дроны ответственно и в соответствии с законом. Производители должны обеспечивать, чтобы дроны соответствовали высоким стандартам качества. И, конечно, должны быть законы и правила, которые регулируют использование дронов и устанавливают ответственность за их действия.

Мы также изучаем концепцию "объяснимого ИИ" (XAI), которая направлена на то, чтобы сделать алгоритмы ИИ более понятными и предсказуемыми. Если мы сможем понять, почему дрон принял то или иное решение, будет легче определить, кто несет ответственность за его действия.

Прозрачность: Открытие "черного ящика"

Многие алгоритмы ИИ работают как "черные ящики". Мы знаем, что они делают, но не знаем, как они это делают. Это может быть проблемой, особенно когда речь идет о принятии важных решений; Мы должны стремиться к тому, чтобы сделать алгоритмы ИИ более прозрачными и понятными.

Это включает в себя:

- Документирование алгоритмов: Описывать, как работают алгоритмы и какие данные они используют.

- Визуализация алгоритмов: Создавать графические представления алгоритмов, чтобы их было легче понять.

- Тестирование алгоритмов: Тщательно тестировать алгоритмы в различных условиях, чтобы убедиться, что они работают правильно.

- Открытый исходный код: Делиться исходным кодом алгоритмов с другими разработчиками, чтобы они могли их проверять и улучшать.

Мы также работаем над созданием инструментов, которые позволяют пользователям задавать вопросы алгоритмам ИИ и получать объяснения их решений. Это может помочь людям понять, как работают алгоритмы, и доверять им больше.

Справедливость: Избежание предвзятости

Алгоритмы ИИ могут быть предвзятыми, если они обучаются на предвзятых данных. Например, если система распознавания лиц обучается только на фотографиях белых людей, она может хуже распознавать лица людей других рас. Мы должны сделать все возможное, чтобы избежать предвзятости в алгоритмах ИИ.

Это включает в себя:

- Сбор разнообразных данных: Собирать данные от разных групп людей, чтобы алгоритмы были справедливыми для всех.

- Анализ данных на предвзятость: Искать признаки предвзятости в данных и исправлять их.

- Тестирование алгоритмов на предвзятость: Тщательно тестировать алгоритмы на разных группах людей, чтобы убедиться, что они работают справедливо.

- Использование алгоритмов, которые устойчивы к предвзятости: Использовать алгоритмы, которые специально разработаны для того, чтобы быть справедливыми.

Мы также работаем над созданием инструментов, которые позволяют обнаруживать и исправлять предвзятость в алгоритмах ИИ. Это сложная задача, но она имеет решающее значение для обеспечения того, чтобы ИИ использовался справедливо и этично.

Наши уроки и рекомендации

За время работы над проектом мы вынесли несколько важных уроков:

- Этика должна быть приоритетом с самого начала: Не ждите, пока возникнет проблема, чтобы начать думать об этике.

- Сотрудничайте с экспертами по этике: Привлекайте экспертов по этике к разработке ИИ, чтобы они могли помочь вам выявить и решить этические проблемы.

- Будьте прозрачными: Делитесь информацией о том, как работают ваши алгоритмы и какие данные они используют.

- Прислушивайтесь к мнению общественности: Узнавайте, что люди думают о ваших технологиях, и учитывайте их мнение.

- Будьте готовы к изменениям: Технологии развиваются быстро, поэтому вы должны быть готовы к тому, что этические вопросы будут меняться со временем.

Мы надеемся, что наш опыт поможет другим разработчикам и пользователям ИИ для дронов решать этические вызовы, возникающие при создании автономных систем. Это сложная задача, но она имеет решающее значение для обеспечения того, чтобы ИИ использовался для блага общества.

Разработка ИИ для дронов – это захватывающее и ответственное занятие. Мы должны постоянно помнить о том, что наши технологии могут иметь далеко идущие последствия для общества. Балансирование между инновациями и этикой – это постоянный процесс, требующий внимания, обсуждения и сотрудничества. Только так мы сможем создать будущее, в котором ИИ используется для улучшения жизни людей, а не для их угнетения.

Подробнее

| ИИ дроны этика | Беспилотники ИИ разработка | Этические аспекты дронов | Приватность дроны | Безопасность ИИ дроны |

|---|---|---|---|---|

| Ответственность ИИ дроны | Прозрачность ИИ | Предвзятость ИИ | Применение ИИ дронов | Регулирование ИИ дронов |