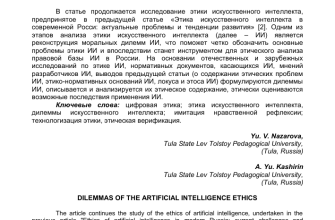

- Этические лабиринты ИИ: Как человеческие данные формируют будущее‚ не разрушая настоящее

- Данные как топливо для ИИ: Что мы отдаем взамен?

- Предвзятость в алгоритмах: Отражение наших собственных ошибок

- Примеры предвзятости: горький опыт

- Конфиденциальность: Где проходит граница?

- Методы защиты конфиденциальности: поиск баланса

- Прозрачность и подотчетность: Кто несет ответственность?

- Регулирование ИИ: необходимость или препятствие?

- Будущее этичного ИИ: наш общий долг

Этические лабиринты ИИ: Как человеческие данные формируют будущее‚ не разрушая настоящее

Мы живем в эпоху‚ когда искусственный интеллект (ИИ) проникает во все сферы нашей жизни. От рекомендаций фильмов до медицинских диагнозов‚ ИИ становится все более влиятельным. Но за этой захватывающей перспективой скрывается сложный этический вопрос: как мы обучаем ИИ‚ используя человеческие данные‚ и какие последствия это влечет за собой? Давайте вместе исследуем этот многогранный вопрос‚ чтобы понять‚ как мы можем построить будущее‚ в котором ИИ служит человечеству‚ не ущемляя его права и свободы.

Данные как топливо для ИИ: Что мы отдаем взамен?

ИИ‚ по сути‚ — это сложная программа‚ которая учится на данных. Чем больше данных мы ей предоставляем‚ тем лучше она становится. Но эти данные часто содержат личную информацию: наши привычки‚ предпочтения‚ даже наши самые сокровенные мысли. Мы щедро делимся этой информацией в социальных сетях‚ при использовании поисковых систем‚ при совершении покупок онлайн. Но осознаем ли мы‚ что эта информация может быть использована для обучения ИИ‚ и какие риски это влечет за собой?

Предвзятость в алгоритмах: Отражение наших собственных ошибок

Одной из самых серьезных проблем является предвзятость в алгоритмах. Если данные‚ на которых обучается ИИ‚ содержат предвзятые представления о расе‚ поле‚ возрасте или других характеристиках‚ ИИ унаследует эти предрассудки. Это может привести к дискриминационным решениям в самых разных областях: от приема на работу до выдачи кредитов. Представьте себе‚ что алгоритм‚ используемый для отбора кандидатов на работу‚ отдает предпочтение мужчинам‚ потому что исторически в компании работало больше мужчин. Это не просто несправедливо‚ это увековечивает неравенство.

Примеры предвзятости: горький опыт

- Системы распознавания лиц: Часто менее точны при распознавании лиц темнокожих людей.

- Алгоритмы оценки рисков в уголовном правосудии: Могут быть предвзяты по отношению к определенным расовым группам.

- Чат-боты: Могут воспроизводить сексистские или расистские высказывания‚ если они были обучены на данных‚ содержащих подобные высказывания.

Мы должны активно бороться с предвзятостью в алгоритмах‚ обеспечивая разнообразие данных‚ используемых для обучения ИИ‚ и тщательно тестируя алгоритмы на наличие предвзятости.

Конфиденциальность: Где проходит граница?

Другой важный этический вопрос, это конфиденциальность. Как мы можем защитить личную информацию людей‚ когда она используется для обучения ИИ? Ведь даже если данные анонимизированы‚ их часто можно деанонимизировать с помощью различных методов. Представьте себе‚ что компания собирает данные о ваших покупках в интернете и использует их для создания персонализированной рекламы. Это удобно‚ но как далеко они могут зайти? Могут ли они продавать эту информацию другим компаниям? Могут ли они использовать ее для манипулирования вашим поведением?

Методы защиты конфиденциальности: поиск баланса

- Анонимизация данных: Удаление или сокрытие личной информации;

- Дифференциальная конфиденциальность: Добавление небольшого шума к данным‚ чтобы защитить конфиденциальность отдельных лиц.

- Федеративное обучение: Обучение ИИ на данных‚ хранящихся на устройствах пользователей‚ без необходимости передавать эти данные на центральный сервер.

Необходимо найти баланс между использованием данных для обучения ИИ и защитой конфиденциальности людей. Нужны строгие правила и механизмы контроля‚ чтобы гарантировать‚ что личная информация не будет использоваться неправомерно.

"Технологический прогресс подобен топору в руках патологического преступника." ⸺ Альберт Эйнштейн

Прозрачность и подотчетность: Кто несет ответственность?

Когда ИИ принимает решения‚ которые влияют на нашу жизнь‚ важно понимать‚ как он это делает. Мы должны знать‚ какие данные использовались для обучения ИИ‚ какие алгоритмы применялись‚ и почему было принято то или иное решение. Это необходимо для того‚ чтобы мы могли доверять ИИ и привлекать его к ответственности за свои действия. Представьте себе‚ что вам отказывают в кредите из-за решения‚ принятого ИИ. У вас должно быть право узнать‚ почему это произошло‚ и оспорить это решение‚ если вы считаете его несправедливым.

Регулирование ИИ: необходимость или препятствие?

Вопрос о регулировании ИИ вызывает много споров. Одни считают‚ что регулирование необходимо для защиты прав и свобод людей. Другие опасаются‚ что регулирование задушит инновации и замедлит развитие ИИ. Нам кажется‚ что необходим разумный подход‚ который позволит нам воспользоваться преимуществами ИИ‚ не игнорируя при этом этические риски. Регулирование должно быть гибким и адаптивным‚ чтобы учитывать быстрое развитие технологий.

Будущее этичного ИИ: наш общий долг

Создание этичного ИИ, это задача‚ которая требует усилий от всех нас: разработчиков‚ политиков‚ ученых‚ и обычных пользователей. Мы должны быть внимательными к этическим вопросам‚ связанным с ИИ‚ и активно участвовать в обсуждении этих вопросов. Мы должны требовать от компаний‚ разрабатывающих ИИ‚ прозрачности и подотчетности. Мы должны поддерживать исследования в области этики ИИ. Только вместе мы сможем построить будущее‚ в котором ИИ будет служить человечеству‚ а не наоборот.

Подробнее

| LSI Запрос 1 | LSI Запрос 2 | LSI Запрос 3 | LSI Запрос 4 | LSI Запрос 5 |

|---|---|---|---|---|

| Этика искусственного интеллекта | Предвзятость в ИИ | Конфиденциальность данных в ИИ | Регулирование искусственного интеллекта | Ответственность ИИ |

| LSI Запрос 6 | LSI Запрос 7 | LSI Запрос 8 | LSI Запрос 9 | LSI Запрос 10 |

| Анонимизация данных | Дискриминация в алгоритмах | Прозрачность ИИ | Использование личных данных ИИ | Влияние ИИ на общество |