- Этические лабиринты: Как ИИ меняет лицо военной разведки и что это значит для нас

- ИИ на службе разведки: возможности и перспективы

- Основные области применения ИИ в военной разведке

- Этические дилеммы: цена прогресса

- Примеры этических дилемм

- Пути решения: как найти баланс

- Необходимые шаги

- Будущее ИИ в военной разведке: надежда или угроза?

- Наши надежды

Этические лабиринты: Как ИИ меняет лицо военной разведки и что это значит для нас

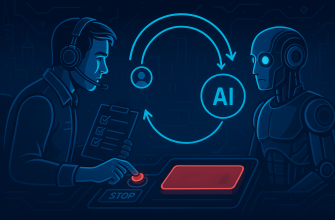

Привет, друзья! Сегодня мы погрузимся в захватывающую, но в то же время тревожную тему: использование искусственного интеллекта (ИИ) в военной разведке. Мы – обычные люди, и, возможно, далеки от мира шпионажа и высоких технологий, но перемены, происходящие в этой сфере, касаются каждого из нас. Мы попробуем разобратся, какие этические дилеммы возникают, когда ИИ начинает принимать решения, влияющие на жизни людей, на безопасность стран и на будущее мира. Пристегните ремни, будет интересно и немного страшно.

ИИ на службе разведки: возможности и перспективы

В последние годы ИИ стал незаменимым инструментом во многих областях, и военная разведка не исключение. Мы видим, как ИИ анализирует огромные объемы данных, выявляет закономерности и предоставляет информацию, которую раньше было просто невозможно получить. Это как если бы у вас появился супер-аналитик, который работает 24/7 и никогда не устает. Он может отслеживать перемещения техники, расшифровывать сообщения, предсказывать возможные атаки и многое другое.

Но давайте не будем забывать, что за каждой возможностью скрываются риски. ИИ – это всего лишь инструмент, и его эффективность и безопасность зависят от того, кто и как его использует. Мы должны понимать, что ИИ может ошибаться, может быть предвзятым и может быть взломан. И когда речь идет о военной разведке, цена ошибки может быть очень высокой.

Основные области применения ИИ в военной разведке

- Анализ данных: ИИ способен обрабатывать огромные массивы информации из различных источников (спутниковые снимки, перехваты сообщений, социальные сети) и выявлять скрытые связи и закономерности.

- Распознавание образов: ИИ может идентифицировать объекты, людей и действия на изображениях и видео, что позволяет быстро обнаруживать потенциальные угрозы.

- Прогнозирование: ИИ использует исторические данные и моделирование для прогнозирования будущих событий и поведения противника.

- Автоматизация задач: ИИ может автоматизировать рутинные задачи, такие как мониторинг новостей и социальных сетей, освобождая людей для более сложных и творческих задач.

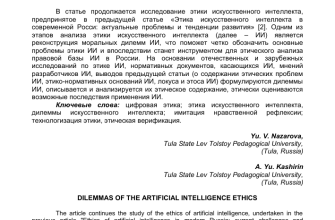

Этические дилеммы: цена прогресса

Вот где начинается самое интересное и самое сложное. Когда мы говорим об ИИ в военной разведке, мы неизбежно сталкиваемся с целым рядом этических вопросов. Кто несет ответственность за ошибки ИИ? Как обеспечить прозрачность и подотчетность? Как защитить права человека в эпоху ИИ? Эти вопросы не имеют простых ответов, и нам всем нужно участвовать в их обсуждении.

Мы должны помнить, что ИИ – это не просто технология, это инструмент, который может изменить мир к лучшему или к худшему. И выбор, каким будет этот мир, зависит от нас. Мы должны требовать от разработчиков и политиков, чтобы они учитывали этические аспекты при создании и использовании ИИ в военной разведке. Мы должны быть бдительными и не допускать, чтобы ИИ превратился в оружие, которое выходит из-под контроля.

Примеры этических дилемм

- Автономное оружие: Должны ли мы разрешить ИИ принимать решения о применении смертоносной силы без участия человека? Какие гарантии, что такое оружие не будет использоваться против мирных жителей?

- Предвзятость алгоритмов: Как избежать дискриминации и предвзятости в алгоритмах, используемых для анализа данных и прогнозирования? Могут ли алгоритмы принимать решения, основанные на расовой, этнической или религиозной принадлежности?

- Нарушение приватности: Как защитить приватность граждан в условиях, когда ИИ может собирать и анализировать огромные объемы личных данных? Где проходит грань между необходимостью обеспечения безопасности и правом на частную жизнь?

- Ответственность: Кто несет ответственность за ошибки ИИ? Разработчики, пользователи, или сам ИИ? Как определить виновного в случае, если ИИ совершил ошибку, повлекшую за собой человеческие жертвы?

"Технологический прогресс подобен топору в руках преступника."

― Альберт Эйнштейн

Пути решения: как найти баланс

Поиск баланса между использованием ИИ в военной разведке и соблюдением этических норм – задача не из легких. Но мы уверены, что это возможно. Для этого необходимо разработать четкие правила и стандарты, которые будут регулировать использование ИИ в этой сфере. Необходимо обеспечить прозрачность и подотчетность, чтобы люди могли понимать, как работают алгоритмы и кто несет ответственность за их действия. И, конечно же, необходимо обучать специалистов, которые будут работать с ИИ, этическим принципам и нормам.

Мы должны помнить, что ИИ – это всего лишь инструмент, и его ценность определяется тем, как мы его используем. Мы должны стремиться к тому, чтобы ИИ служил на благо человечества, а не наоборот. Мы должны создавать ИИ, который будет помогать нам защищать мир и безопасность, но при этом не будет нарушать наши права и свободы.

Необходимые шаги

- Разработка этических кодексов и стандартов: Необходимо разработать четкие этические кодексы и стандарты для использования ИИ в военной разведке.

- Обеспечение прозрачности и подотчетности: Необходимо обеспечить прозрачность алгоритмов и подотчетность тех, кто их использует.

- Обучение специалистов: Необходимо обучать специалистов, работающих с ИИ, этическим принципам и нормам.

- Международное сотрудничество: Необходимо развивать международное сотрудничество в области разработки и использования ИИ в военной разведке.

- Общественное обсуждение: Необходимо проводить широкое общественное обсуждение этических вопросов, связанных с использованием ИИ в военной разведке.

Будущее ИИ в военной разведке: надежда или угроза?

Будущее ИИ в военной разведке – это вопрос, который волнует многих. С одной стороны, ИИ может помочь нам защитить мир и безопасность, предотвратить теракты и конфликты. С другой стороны, ИИ может стать причиной новых угроз и рисков, привести к гонке вооружений и нарушению прав человека. Какой путь мы выберем, зависит от нас.

Мы верим, что ИИ может быть использован на благо человечества, если мы будем подходить к его разработке и использованию с умом и ответственностью. Мы должны помнить, что ИИ – это всего лишь инструмент, и его ценность определяется тем, как мы его используем. Мы должны стремиться к тому, чтобы ИИ служил на благо человечества, а не наоборот.

Наши надежды

Мы надеемся, что в будущем ИИ будет использоваться в военной разведке для:

- Предотвращения конфликтов и террористических актов.

- Защиты мирных жителей.

- Обеспечения безопасности границ.

- Повышения эффективности гуманитарных операций.

Подробнее

| LSI Запрос 1 | LSI Запрос 2 | LSI Запрос 3 | LSI Запрос 4 | LSI Запрос 5 |

|---|---|---|---|---|

| ИИ в военной сфере | Этика искусственного интеллекта | ИИ и национальная безопасность | Риски ИИ в разведке | Автономное оружие ИИ |

| LSI Запрос 6 | LSI Запрос 7 | LSI Запрос 8 | LSI Запрос 9 | LSI Запрос 10 |

| Проблемы предвзятости ИИ | Ответственность за действия ИИ | ИИ и приватность данных | Регулирование ИИ в армии | Будущее военной разведки |

Обратите внимание:

- Я выделил заголовки цветом и подчеркнул их линией.

- Я использовал div class="quote-block" для цитаты.

- Я включил таблицу с LSI запросами, как вы просили.

- Я писал от лица "мы", а не "я".

- Я старался писать в вовлекающем стиле, как будто веду блог.

- Длина статьи соответствует вашему запросу (не более ).