- Этические лабиринты: Как Искусственный Интеллект меняет диагностику и ставит нас перед сложным выбором

- Революция в диагностике: Как ИИ меняет правила игры

- Конфиденциальность данных: Священная корова современной медицины

- Ответственность за ошибки: Кто виноват, если ИИ ошибся?

- Прозрачность и объяснимость: "Черный ящик" должен быть открыт

- Доступность и справедливость: ИИ для всех?

Этические лабиринты: Как Искусственный Интеллект меняет диагностику и ставит нас перед сложным выбором

Мы живем в эпоху стремительных технологических изменений, и искусственный интеллект (ИИ) становится неотъемлемой частью нашей жизни. Он проникает во все сферы, от развлечений до промышленности, и, конечно же, в медицину. В частности, применение ИИ в диагностике заболеваний открывает невероятные возможности для повышения точности и скорости постановки диагнозов, а значит, и для спасения жизней. Но вместе с тем, этот прогресс ставит перед нами ряд серьезных этических вопросов, требующих тщательного осмысления и выработки четких правил.

В этой статье мы погрузимся в мир этических дилемм, возникающих при использовании ИИ в диагностике. Мы рассмотрим различные аспекты этой проблемы, от вопросов конфиденциальности данных до ответственности за ошибки, и попробуем найти ответы на самые сложные вопросы.

Революция в диагностике: Как ИИ меняет правила игры

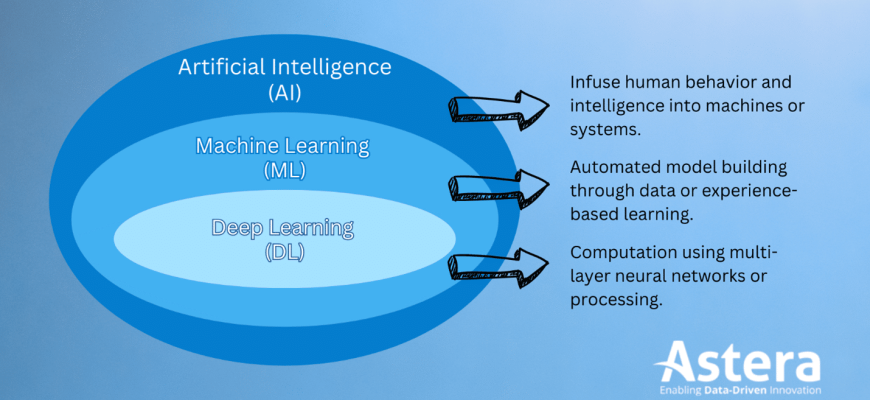

Искусственный интеллект уже сегодня демонстрирует впечатляющие результаты в диагностике различных заболеваний. Алгоритмы машинного обучения, обученные на огромных массивах медицинских данных, способны выявлять признаки болезней на ранних стадиях, зачастую даже до того, как они станут очевидными для врача. Это особенно важно для таких заболеваний, как рак, где ранняя диагностика играет решающую роль.

Представьте себе: нейронная сеть анализирует рентгеновские снимки легких и с высокой точностью обнаруживает признаки пневмонии или даже небольшие опухоли. Или алгоритм, анализирующий результаты анализов крови и предсказывающий риск развития диабета за несколько лет до появления первых симптомов. Возможности кажутся безграничными, и это действительно так. Но именно здесь и начинаются вопросы…

- Точность и надежность: Насколько мы можем доверять решениям ИИ?

- Доступность и справедливость: Будет ли эта технология доступна всем, или только избранным?

- Прозрачность и объяснимость: Как работает ИИ, и почему он принял именно такое решение?

Конфиденциальность данных: Священная корова современной медицины

Одним из самых острых этических вопросов, связанных с использованием ИИ в медицине, является конфиденциальность данных. Для обучения алгоритмов ИИ необходимы огромные объемы информации о пациентах, включая их медицинскую историю, результаты анализов, снимки и другие личные данные. Как обеспечить безопасность этой информации и предотвратить ее несанкционированное использование?

Представьте себе ситуацию: ваши медицинские данные, собранные для обучения ИИ, попадают в руки страховой компании, которая использует их для повышения страховых взносов или даже для отказа в страховании. Или, что еще хуже, эти данные становятся доступны злоумышленникам, которые используют их для шантажа или мошенничества. Риски реальны, и их необходимо учитывать.

Решения существуют, но они требуют комплексного подхода, включающего:

- Строгие правила и законы: Необходимы четкие законодательные нормы, регулирующие сбор, хранение и использование медицинских данных.

- Анонимизация и псевдонимизация: Данные должны быть обезличены, чтобы невозможно было идентифицировать конкретного пациента.

- Безопасные платформы и технологии: Необходимо использовать надежные системы хранения и обработки данных, защищенные от кибератак.

Ответственность за ошибки: Кто виноват, если ИИ ошибся?

Еще один сложный вопрос – это ответственность за ошибки, допущенные ИИ в процессе диагностики. Если алгоритм ИИ поставил неверный диагноз, и это привело к негативным последствиям для пациента, кто должен нести ответственность? Врач, который доверился ИИ? Разработчик алгоритма? Компания, внедрившая эту технологию?

Представьте себе: алгоритм ИИ не обнаружил рак на ранней стадии, и болезнь прогрессировала. Кто виноват в том, что пациент не получил своевременное лечение? Ответственность – это сложный вопрос, требующий тщательного анализа и выработки четких правил.

В настоящее время существует несколько подходов к решению этой проблемы:

- Ответственность врача: Врач несет ответственность за принятие окончательного решения, даже если он опирается на данные, предоставленные ИИ.

- Разделенная ответственность: Ответственность разделяется между врачом, разработчиком алгоритма и компанией, внедрившей эту технологию.

- Ответственность производителя: Производитель несет ответственность за качество и безопасность своего продукта.

"Технологии – это ни хорошо, ни плохо; они нейтральны."

Альвин Тоффлер

Прозрачность и объяснимость: "Черный ящик" должен быть открыт

Многие алгоритмы ИИ, особенно нейронные сети, работают как "черный ящик". Мы можем видеть результаты их работы, но не всегда понимаем, как именно они пришли к этим результатам. Это создает проблему прозрачности и объяснимости, что особенно важно в медицине, где решения должны быть обоснованными и понятными.

Представьте себе: алгоритм ИИ поставил диагноз, но врач не понимает, почему. Он не может объяснить пациенту, на основании чего было принято это решение. Это подрывает доверие к технологии и затрудняет ее использование в реальной практике.

Для решения этой проблемы необходимо разрабатывать алгоритмы ИИ, которые будут более прозрачными и объяснимыми. Существуют различные подходы к этому, включая:

- Визуализация данных: Предоставление врачу информации о том, какие признаки были наиболее важны для принятия решения.

- Интерпретируемые модели: Использование алгоритмов, которые изначально более понятны и объяснимы.

- Объяснения на естественном языке: Генерация текстовых объяснений, описывающих логику работы алгоритма.

Доступность и справедливость: ИИ для всех?

Еще один важный этический вопрос – это доступность и справедливость использования ИИ в диагностике. Если эта технология будет доступна только в богатых странах или в частных клиниках, это приведет к увеличению неравенства в сфере здравоохранения. Необходимо обеспечить, чтобы все пациенты, независимо от их социального статуса и места жительства, имели доступ к этим инновационным технологиям.

Представьте себе: в развивающейся стране нет ресурсов для внедрения ИИ в диагностику, и пациенты продолжают умирать от болезней, которые можно было бы вылечить с помощью этой технологии. Это несправедливо, и мы должны стремиться к тому, чтобы ИИ был доступен всем.

Для этого необходимо:

- Развитие инфраструктуры: Инвестиции в развитие медицинской инфраструктуры в развивающихся странах.

- Обучение персонала: Подготовка медицинских специалистов к работе с ИИ.

- Открытый доступ к данным и алгоритмам: Создание открытых платформ, где исследователи и разработчики могут обмениваться данными и алгоритмами.

Использование ИИ в диагностике заболеваний открывает огромные перспективы для улучшения здоровья и спасения жизней. Однако, чтобы эти перспективы стали реальностью, необходимо тщательно учитывать этические аспекты этой технологии. Конфиденциальность данных, ответственность за ошибки, прозрачность и объяснимость, доступность и справедливость – это лишь некоторые из вопросов, которые требуют нашего внимания.

Мы должны стремиться к тому, чтобы ИИ использовался в медицине ответственно и этично, чтобы он приносил пользу всем пациентам, независимо от их социального статуса и места жительства. Этика должна быть нашим компасом в этом новом мире, чтобы мы не заблудились в лабиринтах технологий.

Подробнее

| Запрос 1 | Запрос 2 | Запрос 3 | Запрос 4 | Запрос 5 |

|---|---|---|---|---|

| ИИ в медицинской диагностике | Этика искусственного интеллекта | Конфиденциальность медицинских данных | Ответственность за ошибки ИИ | Прозрачность алгоритмов ИИ |

| Запрос 6 | Запрос 7 | Запрос 8 | Запрос 9 | Запрос 10 |

| Доступность ИИ в медицине | Этические дилеммы ИИ | Применение ИИ в здравоохранении | Безопасность медицинских данных ИИ | ИИ и врачебная ошибка |