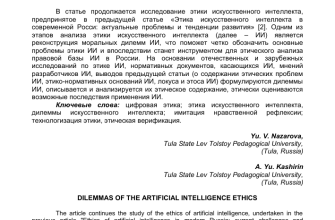

Этические лабиринты кибербезопасности: Как ИИ меняет правила игры

Приветствую, друзья! Сегодня мы погрузимся в захватывающий и вместе с тем тревожный мир кибербезопасности, где искусственный интеллект (ИИ) становится не просто инструментом, а ключевым игроком. Мы, как специалисты и просто интересующиеся, должны понимать, что с развитием технологий растут и риски, и вопросы этики. Как далеко мы можем зайти в использовании ИИ для защиты от киберугроз? Какие границы нельзя переступать? Давайте разбираться вместе.

Вспомните классические фильмы о киберпанке, где машины борются с машинами, а человек становится лишь пешкой в этой игре. Раньше это казалось фантастикой, но сегодня элементы этого мира уже здесь. ИИ способен анализировать огромные объемы данных, выявлять аномалии и даже предсказывать атаки. Но что, если этот же ИИ будет использован во вред? Вопросы этики в кибербезопасности становятся все более актуальными.

ИИ в кибербезопасности: Друг или враг?

Искусственный интеллект предлагает беспрецедентные возможности для защиты от киберугроз. Он способен автоматизировать рутинные задачи, такие как обнаружение вредоносного ПО и анализ трафика, освобождая ресурсы для более сложных задач. ИИ может обучаться на новых данных, адаптируясь к меняющимся угрозам и даже предсказывая новые типы атак. Это как иметь круглосуточного бдительного стража, который никогда не устает.

Однако, как и любая мощная технология, ИИ имеет и темную сторону. Злоумышленники также используют ИИ для создания более сложных и изощренных атак. Они могут использовать его для автоматизации фишинга, создания более убедительных подделок и даже для обхода систем безопасности, разработанных на основе ИИ. Получается гонка вооружений, где каждая сторона пытается перехитрить другую.

Основные этические дилеммы

Когда мы говорим об этике ИИ в кибербезопасности, мы сталкиваемся с рядом сложных вопросов. Один из самых важных – это вопрос приватности. ИИ для анализа угроз требует доступа к огромным объемам данных, включая персональные данные пользователей. Как обеспечить защиту этих данных и не допустить злоупотреблений?

- Приватность данных: Как ИИ должен обрабатывать и защищать личные данные?

- Автономия решений: Должен ли ИИ принимать решения самостоятельно, или всегда требуется участие человека?

- Прозрачность алгоритмов: Как обеспечить понимание и контроль над решениями, принимаемыми ИИ?

- Ответственность: Кто несет ответственность за ошибки и сбои в работе ИИ?

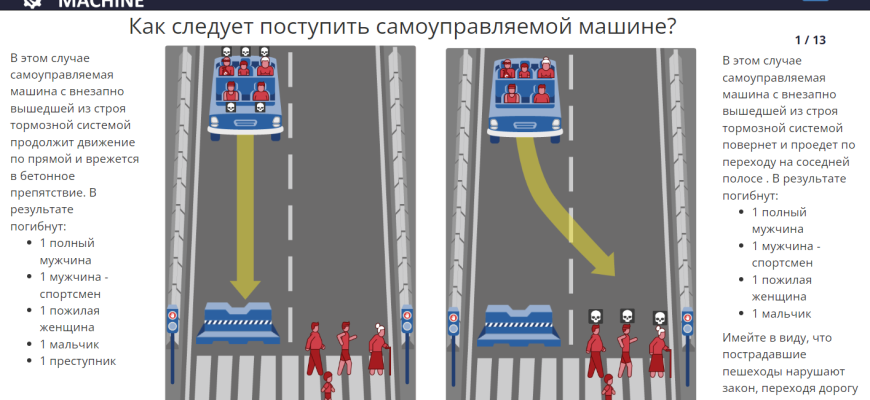

Другая важная дилемма – это автономия решений. Должен ли ИИ самостоятельно принимать решения об ответных мерах на кибератаки? Или всегда требуется участие человека? С одной стороны, автоматизированные решения могут быть быстрее и эффективнее. С другой стороны, они могут привести к непредсказуемым последствиям и даже к ложным обвинениям.

Прозрачность и объяснимость ИИ

Одна из главных проблем с ИИ – это его непрозрачность. Многие алгоритмы машинного обучения работают как "черный ящик", и мы не всегда можем понять, почему они приняли то или иное решение. Это особенно проблематично в кибербезопасности, где каждое решение может иметь серьезные последствия. Нам необходимо разрабатывать методы, которые позволяют "объяснить" решения, принимаемые ИИ, и убедиться, что они соответствуют нашим этическим принципам.

Представьте ситуацию: ИИ обнаружил подозрительную активность на сервере и автоматически заблокировал доступ к нему. Но что, если это была ложная тревога, и в результате блокировки важные бизнес-процессы были остановлены? Если мы не можем понять, почему ИИ принял такое решение, мы не можем доверять ему полностью. Нам нужны инструменты, которые позволяют нам "заглянуть внутрь" алгоритма и понять его логику.

"Технологический прогресс не может быть остановлен, но мы должны направлять его в правильное русло, чтобы он служил человечеству, а не наоборот."

౼ Стивен Хокинг

Принципы этичного использования ИИ в кибербезопасности

Какие же принципы должны лежать в основе этичного использования ИИ в кибербезопасности? Мы считаем, что необходимо придерживаться следующих правил:

- Защита приватности: Использовать ИИ только для защиты от реальных угроз, а не для сбора и анализа персональных данных без согласия пользователей.

- Прозрачность и объяснимость: Стремиться к тому, чтобы решения, принимаемые ИИ, были понятны и объяснимы.

- Ответственность: Четко определять, кто несет ответственность за ошибки и сбои в работе ИИ.

- Человеческий контроль: Обеспечить возможность вмешательства человека в процесс принятия решений ИИ, особенно в критических ситуациях.

- Предотвращение дискриминации: Убедиться, что ИИ не использует данные, которые могут привести к дискриминации определенных групп пользователей.

Эти принципы – это не просто красивые слова, а руководство к действию. Мы должны внедрять их в процесс разработки и использования ИИ в кибербезопасности, чтобы обеспечить безопасность и защиту прав всех пользователей.

Практические шаги для внедрения этических норм

Как же внедрить эти принципы на практике? Вот несколько конкретных шагов, которые мы можем предпринять:

- Разработка этических кодексов и стандартов: Создание четких правил и рекомендаций для разработчиков и пользователей ИИ в кибербезопасности.

- Обучение и повышение квалификации: Обучение специалистов в области кибербезопасности этическим аспектам использования ИИ.

- Разработка инструментов для оценки рисков: Создание инструментов, которые позволяют оценивать этические риски, связанные с использованием ИИ в кибербезопасности.

- Создание механизмов контроля и надзора: Создание независимых организаций, которые будут контролировать соблюдение этических норм в области использования ИИ в кибербезопасности.

Эти шаги требуют усилий и сотрудничества со стороны всех заинтересованных сторон: разработчиков, пользователей, правительственных организаций и экспертов в области этики. Только вместе мы сможем создать безопасный и этичный мир киберпространства.

Будущее ИИ в кибербезопасности

Будущее ИИ в кибербезопасности выглядит одновременно захватывающим и тревожным. С одной стороны, мы можем ожидать появления еще более мощных и эффективных систем защиты, которые смогут предсказывать и предотвращать даже самые сложные кибератаки. С другой стороны, мы должны быть готовы к тому, что злоумышленники также будут использовать ИИ для создания все более изощренных угроз. Гонка вооружений между защитниками и нападающими будет продолжаться, и нам необходимо быть на шаг впереди.

Важно помнить, что ИИ – это всего лишь инструмент. Его эффективность и влияние на мир зависят от того, как мы его используем. Мы должны стремиться к тому, чтобы ИИ служил человечеству, а не наоборот. Это требует от нас ответственности, бдительности и постоянного внимания к этическим аспектам развития технологий.

Подробнее

| Этика ИИ в киберзащите | Моральные аспекты ИИ | ИИ и приватность | ИИ и ответственность | Автономия ИИ в кибербезопасности |

|---|---|---|---|---|

| Прозрачность алгоритмов ИИ | Кибербезопасность и предвзятость ИИ | Защита данных с помощью ИИ | Этические рамки для машинного обучения | ИИ как оружие кибервойны |