- Этика ИИ в области автономного оружия: Цена прогресса

- Автономное оружие: Что это такое и почему это важно?

- Аргументы "за": Повышение эффективности и снижение потерь

- Аргументы "против": Этические дилеммы и угроза неконтролируемой эскалации

- Этические принципы и международное право

- ИИ и моральный выбор: Может ли машина быть моральной?

- Будущее автономного оружия: Сценарии развития

- Что можем сделать мы?

Этика ИИ в области автономного оружия: Цена прогресса

Мир меняется с невероятной скоростью‚ и искусственный интеллект (ИИ) играет в этом процессе ключевую роль. Мы‚ как блогеры‚ постоянно наблюдаем за тем‚ как ИИ проникает во все сферы нашей жизни‚ от развлечений до медицины. Но есть одна область‚ где его применение вызывает особенно много споров и тревог – это автономное оружие (LAWS). Сегодня мы поговорим о сложных этических вопросах‚ которые встают перед нами‚ когда речь заходит о машинах‚ способных принимать решения о жизни и смерти.

Использование ИИ в военной сфере – это не просто вопрос технологического прогресса‚ это вопрос нашей ответственности перед будущими поколениями. Мы должны понимать‚ какие риски и возможности несет в себе эта технология‚ и как нам избежать катастрофических последствий.

Автономное оружие: Что это такое и почему это важно?

Прежде чем углубиться в этические дебри‚ давайте разберемся‚ что же такое автономное оружие. Под этим термином подразумеваються системы вооружения‚ которые способны самостоятельно выбирать и поражать цели без участия человека. То есть‚ машина принимает решение о применении силы‚ основываясь на заложенных в нее алгоритмах и данных‚ полученных от сенсоров.

Почему это важно? Потому что это кардинально меняет правила игры. Традиционно‚ решение об использовании оружия принимает человек‚ который несет ответственность за свои действия. В случае с автономным оружием‚ эта ответственность размывается. Кто виноват‚ если машина совершит ошибку и убьет невинного человека? Разработчик‚ командир‚ или сама машина?

Аргументы "за": Повышение эффективности и снижение потерь

Сторонники разработки и применения автономного оружия утверждают‚ что оно может сделать войну более эффективной и менее кровопролитной. Они приводят следующие аргументы:

- Скорость и точность: Машины могут реагировать на угрозы гораздо быстрее и точнее‚ чем человек.

- Снижение человеческих потерь: Использование автономного оружия может позволить избежать гибели солдат на поле боя.

- Минимизация ошибок: Машины не подвержены эмоциям и стрессу‚ что может снизить вероятность ошибок‚ связанных с человеческим фактором.

- Выполнение сложных задач: Автономное оружие может быть использовано для выполнения задач‚ которые слишком опасны или сложны для человека.

Несомненно‚ эти аргументы имеют право на существование. Однако‚ они не учитывают всех возможных последствий и рисков.

Аргументы "против": Этические дилеммы и угроза неконтролируемой эскалации

Противники автономного оружия выдвигают серьезные аргументы‚ основанные на этических соображениях и опасениях по поводу безопасности:

- Ответственность: Кто будет нести ответственность за ошибки и преступления‚ совершенные автономным оружием?

- Этические дилеммы: Как машина сможет принимать решения в сложных ситуациях‚ требующих морального выбора?

- Гуманность: Может ли машина обладать достаточной эмпатией и пониманием‚ чтобы отличать комбатантов от некомбатантов?

- Неконтролируемая эскалация: Разработка и применение автономного оружия может привести к гонке вооружений и неконтролируемой эскалации конфликтов.

- Уязвимость к взлому: Автономное оружие может быть взломано и использовано злоумышленниками.

Эти опасения вполне обоснованы. Представьте себе ситуацию‚ когда автономное оружие‚ запрограммированное на уничтожение вражеских танков‚ ошибочно идентифицирует гражданский автомобиль как танк и уничтожает его. Кто будет нести ответственность за гибель невинных людей?

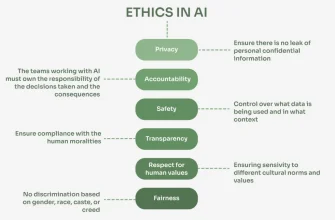

Этические принципы и международное право

Вопросы этики и международного права играют ключевую роль в обсуждении автономного оружия. Существующие нормы международного гуманитарного права‚ такие как принципы различия‚ пропорциональности и предосторожности‚ были разработаны в эпоху‚ когда оружием управляли люди. Как эти принципы могут быть применены к автономному оружию?

Некоторые эксперты считают‚ что необходимо разработать новые международные нормы и правила‚ которые регулировали бы разработку‚ применение и распространение автономного оружия. Другие предлагают вообще запретить его разработку и использование‚ считая‚ что оно представляет слишком большую угрозу для человечества.

"Я боюсь того дня‚ когда технологии превзойдут человеческое общение. В мире будет поколение идиотов." ౼ Альберт Эйнштейн

ИИ и моральный выбор: Может ли машина быть моральной?

Один из самых сложных вопросов‚ связанных с автономным оружием‚ – это вопрос о возможности создания моральной машины. Может ли ИИ обладать достаточным уровнем сознания‚ эмпатии и понимания‚ чтобы принимать морально оправданные решения в сложных ситуациях?

Многие ученые и философы считают‚ что это невозможно. Они утверждают‚ что мораль – это продукт человеческого опыта‚ культуры и социальных отношений‚ и что машина‚ даже самая совершенная‚ не может обладать этими качествами.

Однако‚ другие исследователи полагают‚ что возможно создание ИИ‚ который будет способен учитывать этические принципы и принимать решения‚ соответствующие моральным нормам. Они предлагают разрабатывать алгоритмы‚ которые будут учитывать контекст ситуации‚ оценивать возможные последствия и выбирать наиболее гуманный вариант действий.

В любом случае‚ это очень сложная задача‚ требующая серьезных исследований и дискуссий.

Будущее автономного оружия: Сценарии развития

Как будет развиваться ситуация с автономным оружием в будущем? Существует несколько возможных сценариев:

- Международный запрет: В этом сценарии‚ международное сообщество придет к соглашению о полном запрете разработки‚ производства и использования автономного оружия.

- Регулирование и контроль: В этом сценарии‚ будут разработаны и приняты международные нормы и правила‚ которые будут регулировать разработку‚ применение и распространение автономного оружия.

Какой из этих сценариев окажется наиболее вероятным‚ покажет время. Однако‚ мы‚ как общество‚ должны активно участвовать в обсуждении этой проблемы и требовать от наших правительств ответственных решений.

Что можем сделать мы?

Вопрос этики ИИ в области автономного оружия касается каждого из нас. Мы не можем просто стоять в стороне и наблюдать за тем‚ как принимаются решения‚ которые могут повлиять на будущее всего человечества. Что мы можем сделать?

- Информироваться: Узнавайте больше об автономном оружии‚ его рисках и возможностях. Читайте научные статьи‚ смотрите документальные фильмы‚ участвуйте в дискуссиях.

- Высказывать свое мнение: Пишите письма своим представителям в правительстве‚ участвуйте в онлайн-петициях‚ организуйте акции протеста.

- Поддерживать организации: Поддерживайте организации‚ которые занимаются исследованиями в области этики ИИ и выступают за ответственное использование технологий.

- Образовывать других: Рассказывайте своим друзьям‚ родственникам и коллегам об опасностях и возможностях автономного оружия.

Вместе мы можем повлиять на будущее автономного оружия и сделать мир более безопасным и гуманным.

Подробнее

| LSI Запрос | LSI Запрос | LSI Запрос | LSI Запрос | LSI Запрос |

|---|---|---|---|---|

| Этика искусственного интеллекта | Автономное оружие определение | Риски автономного оружия | Международное право и ИИ | Контроль над ИИ оружием |

| Моральные машины | Ответственность за ИИ | Будущее военных технологий | Влияние ИИ на войну | Запрет автономного оружия |