- Этика ИИ в сфере безопасности и обороны: Между Защитой и Ответственностью

- ИИ в сфере безопасности и обороны: Обзор

- Ключевые этические вопросы

- Ответственность за действия ИИ

- Предвзятость и дискриминация

- Прозрачность и объяснимость

- Контроль над ИИ

- Автономные системы оружия (ASW): Особые риски

- Международные усилия по регулированию ИИ в сфере безопасности

- Рекомендации для ответственного использования ИИ в сфере безопасности

Этика ИИ в сфере безопасности и обороны: Между Защитой и Ответственностью

В современном мире‚ где технологии развиваются с невероятной скоростью‚ искусственный интеллект (ИИ) становится все более важным элементом в сфере безопасности и обороны․ Мы‚ как свидетели и участники этой технологической революции‚ не можем игнорировать этические вопросы‚ возникающие в связи с применением ИИ в столь чувствительной области․ Как нам обеспечить безопасность‚ не переступая границы морали и ответственности? Как сбалансировать потребность в инновациях с защитой человеческих ценностей?

В этой статье мы погрузимся в мир этических дилемм‚ связанных с использованием ИИ в сфере безопасности и обороны․ Мы рассмотрим ключевые вопросы‚ вызовы и возможные решения‚ чтобы понять‚ как можно использовать мощь ИИ для защиты‚ не ставя под угрозу наши фундаментальные принципы․

ИИ в сфере безопасности и обороны: Обзор

Применение ИИ в военной сфере и сфере безопасности становится все более распространенным․ От автономных систем оружия до анализа данных и кибербезопасности‚ ИИ предлагает огромный потенциал для повышения эффективности и защиты․ Но вместе с этим потенциалом приходят и серьезные риски․

- Автономные системы оружия (ASW): Способны принимать решения о применении силы без участия человека․

- Анализ данных и разведка: ИИ может обрабатывать огромные объемы данных для выявления угроз и прогнозирования событий․

- Кибербезопасность: ИИ используется для защиты от кибератак и обнаружения вредоносного программного обеспечения․

- Системы наблюдения и контроля: ИИ может анализировать видеопотоки и данные с датчиков для обнаружения подозрительной активности․

Эти приложения ИИ могут значительно улучшить нашу способность защищать себя и свои интересы․ Однако‚ они также поднимают серьезные вопросы о контроле‚ ответственности и потенциальных последствиях․

Ключевые этические вопросы

Применение ИИ в сфере безопасности и обороны порождает множество этических вопросов‚ которые требуют тщательного рассмотрения и обсуждения․ Вот некоторые из наиболее важных:

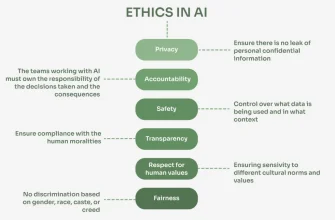

Ответственность за действия ИИ

Кто несет ответственность‚ когда ИИ совершает ошибку или причиняет вред? Разработчик‚ командир‚ правительство? Этот вопрос становиться особенно острым‚ когда речь идет об автономных системах оружия‚ способных принимать решения о жизни и смерти․

Определение ответственности является сложной задачей‚ поскольку ИИ может действовать непредсказуемо‚ особенно в сложных и динамичных ситуациях․ Важно разработать четкие правовые и этические рамки‚ которые определяют ответственность за действия ИИ и обеспечивают возможность привлечения к ответственности в случае необходимости․

Предвзятость и дискриминация

ИИ обучается на данных‚ и если эти данные содержат предвзятости‚ ИИ может воспроизводить и усиливать их․ Это может привести к дискриминации в отношении определенных групп населения‚ например‚ при использовании ИИ для распознавания лиц или анализа данных о преступности․

Чтобы избежать предвзятости и дискриминации‚ необходимо тщательно отбирать и анализировать данные‚ используемые для обучения ИИ․ Также важно разрабатывать алгоритмы‚ которые учитывают возможность предвзятости и стремятся к справедливому и равному отношению ко всем․

Прозрачность и объяснимость

Многие системы ИИ‚ особенно те‚ которые основаны на глубоком обучении‚ являются "черными ящиками"․ Трудно понять‚ почему ИИ принял то или иное решение․ Это может быть проблематично‚ когда речь идет о решениях‚ имеющих серьезные последствия‚ например‚ о применении силы․

Прозрачность и объяснимость ИИ являются важными для обеспечения доверия и подотчетности․ Необходимо разрабатывать методы‚ которые позволяют понимать и объяснять‚ как ИИ принимает решения‚ чтобы можно было выявить и исправить ошибки и предвзятости․

Контроль над ИИ

Как нам гарантировать‚ что ИИ будет использоваться только в соответствии с нашими ценностями и целями? Как предотвратить злоупотребление ИИ или его использование во вред? Этот вопрос становится особенно актуальным по мере того‚ как ИИ становится все более мощным и автономным․

Контроль над ИИ требует разработки эффективных механизмов управления и надзора․ Важно установить четкие правила и ограничения на использование ИИ‚ а также создать системы мониторинга и контроля‚ которые позволяют выявлять и предотвращать злоупотребления․

"Технологии сами по себе не являются ни хорошими‚ ни плохими; ни нейтральными․"

– Мелвин Кранцберг

Автономные системы оружия (ASW): Особые риски

Автономные системы оружия (ASW)‚ также известные как "роботы-убийцы"‚ представляют собой особый вызов для этики ИИ․ Эти системы способны принимать решения о применении силы без участия человека․ Многие эксперты и организации призывают к запрету ASW‚ опасаясь‚ что они могут привести к неконтролируемой эскалации конфликтов‚ случайным жертвам и нарушению международного гуманитарного права․

Вот некоторые из ключевых аргументов против ASW:

- Отсутствие человеческого контроля: ASW могут принимать решения о жизни и смерти без участия человека‚ что противоречит фундаментальным принципам морали и права․

- Риск ошибок и сбоев: ASW могут совершать ошибки или сбои‚ приводящие к случайным жертвам и нежелательным последствиям․

- Эскалация конфликтов: ASW могут ускорить темп войны и увеличить риск эскалации‚ поскольку они способны действовать быстрее и более агрессивно‚ чем люди․

- Невозможность привлечения к ответственности: Сложно определить‚ кто несет ответственность за действия ASW‚ что может привести к безнаказанности за военные преступления․

Несмотря на эти опасения‚ некоторые утверждают‚ что ASW могут быть полезны для снижения риска для солдат и повышения эффективности военных операций․ Однако‚ важно тщательно взвесить все риски и выгоды‚ прежде чем принимать решение о разработке и развертывании ASW․

Международные усилия по регулированию ИИ в сфере безопасности

Международное сообщество осознает необходимость регулирования ИИ в сфере безопасности и обороны․ В настоящее время ведутся дискуссии в рамках ООН и других международных организаций о том‚ как разработать правовые и этические рамки для использования ИИ в военной сфере․

Вот некоторые из ключевых инициатив:

- Конвенция о конкретных видах обычного оружия (CCW): В рамках CCW обсуждаются вопросы‚ связанные с ASW и другими видами оружия‚ использующими ИИ․

- Группа правительственных экспертов (GGE) по летальному автономному оружию: Эта группа‚ созданная в рамках CCW‚ занимается изучением этических‚ правовых и оперативных аспектов ASW․

- Международные неправительственные организации (НПО): Многие НПО‚ такие как Human Rights Watch и Campaign to Stop Killer Robots‚ активно выступают за запрет ASW и продвигают этические принципы использования ИИ в военной сфере․

Несмотря на эти усилия‚ прогресс в регулировании ИИ в сфере безопасности остается медленным и трудным․ Разные страны имеют разные интересы и приоритеты‚ что затрудняет достижение консенсуса․ Однако‚ важно продолжать диалог и сотрудничество‚ чтобы разработать эффективные и справедливые правила использования ИИ в военной сфере․

Рекомендации для ответственного использования ИИ в сфере безопасности

Чтобы обеспечить ответственное использование ИИ в сфере безопасности и обороны‚ мы предлагаем следующие рекомендации:

- Приоритет человеческому контролю: Человек должен всегда сохранять контроль над решениями о применении силы․ Автономные системы оружия‚ способные принимать такие решения без участия человека‚ должны быть запрещены․

- Разработка этических принципов и стандартов: Необходимо разработать четкие этические принципы и стандарты для использования ИИ в военной сфере‚ основанные на принципах гуманности‚ необходимости и соразмерности․

- Обеспечение прозрачности и объяснимости: Системы ИИ должны быть прозрачными и объяснимыми‚ чтобы можно было понимать‚ как они принимают решения и выявлять ошибки и предвзятости․

- Проведение тщательного тестирования и оценки: Системы ИИ должны проходить тщательное тестирование и оценку‚ чтобы убедиться в их надежности и безопасности․

- Установление ответственности: Необходимо установить четкие правовые и этические рамки‚ которые определяют ответственность за действия ИИ и обеспечивают возможность привлечения к ответственности в случае необходимости․

- Сотрудничество и диалог: Необходимо продолжать диалог и сотрудничество между правительствами‚ экспертами‚ НПО и другими заинтересованными сторонами‚ чтобы разработать эффективные и справедливые правила использования ИИ в военной сфере․

Этика ИИ в сфере безопасности и обороны – это сложная и многогранная проблема‚ требующая тщательного рассмотрения и обсуждения․ Мы должны найти баланс между использованием потенциала ИИ для защиты и обеспечением соблюдения наших фундаментальных принципов и ценностей․ Ответственное использование ИИ в военной сфере требует приоритета человеческому контролю‚ разработки этических принципов и стандартов‚ обеспечения прозрачности и объяснимости‚ проведения тщательного тестирования и оценки‚ установления ответственности и сотрудничества и диалога․

Мы верим‚ что‚ работая вместе‚ мы можем использовать мощь ИИ для защиты‚ не ставя под угрозу наши фундаментальные принципы и ценности․ Будущее безопасности и обороны зависит от нашего умения найти правильный путь․

Подробнее

| LSI Запрос | LSI Запрос | LSI Запрос | LSI Запрос | LSI Запрос |

|---|---|---|---|---|

| Этические дилеммы ИИ в обороне | Ответственность за решения ИИ в безопасности | Риски предвзятости ИИ в военных системах | Международное регулирование ИИ в обороне | Автономное оружие и этика |

| Прозрачность алгоритмов ИИ в безопасности | Влияние ИИ на военную стратегию | Этические аспекты кибербезопасности с ИИ | ИИ и права человека в военной сфере | Будущее военных технологий с ИИ |