- Этика Искусственного Интеллекта на Поле Боя: Размышления Очевидца

- Автономные Системы Оружия: Кто Принимает Решение?

- Преимущества и Недостатки Автономности

- ИИ в Разведке и Анализе Данных: Большой Брат Следит за Тобой?

- Этические Вопросы Сбора и Использования Данных

- Кибервойна и ИИ: Невидимый Фронт

- Проблемы Атрибуции и Ответственности

- Обучение ИИ: Предвзятость и Дискриминация

- Примеры Предвзятости в Военных Приложениях ИИ

- Международное Сотрудничество и Регулирование

- Роль ООН и Других Международных Организаций

- Будущее Войны: Этика и Ответственность

Этика Искусственного Интеллекта на Поле Боя: Размышления Очевидца

Приветствую вас‚ дорогие читатели! Сегодня мы погрузимся в тему‚ которая одновременно завораживает и пугает: использование искусственного интеллекта (ИИ) в военном деле․ Мы‚ как обычные люди‚ наблюдаем за развитием технологий‚ и иногда кажется‚ что будущее уже наступило․ Но готовы ли мы к этому будущему‚ особенно когда речь заходит о войне?

Нам кажется важным не просто говорить об ИИ как о чем-то абстрактном‚ но и рассмотреть конкретные этические дилеммы‚ которые возникают при его применении в военной сфере․ Мы будем делиться своими размышлениями‚ задавать вопросы и‚ возможно‚ вместе искать ответы․ Ведь от того‚ как мы сегодня подойдем к этим вопросам‚ зависит наше завтра․

Автономные Системы Оружия: Кто Принимает Решение?

Представьте себе армию роботов‚ способных самостоятельно выбирать и уничтожать цели․ Звучит как сценарий научно-фантастического фильма‚ не так ли? Но это уже реальность․ Разрабатываются и тестируются автономные системы оружия (АСО)‚ которые‚ по сути‚ являются машинами‚ способными принимать решения о жизни и смерти без участия человека․

Нас это пугает․ Кто будет нести ответственность‚ если АСО совершит ошибку и убьет невинного человека? Разработчик‚ командир‚ или сама машина? И можем ли мы вообще доверить машине принимать такие решения? Ведь война – это всегда трагедия‚ но участие человека‚ пусть и ошибающегося‚ подразумевает наличие моральных принципов‚ эмпатии и возможности раскаяния․ А что может предложить машина?

Преимущества и Недостатки Автономности

Сторонники использования АСО утверждают‚ что они могут сделать войну более точной и менее кровопролитной․ Машины не подвержены эмоциям‚ стрессу и усталости‚ что может привести к уменьшению числа ошибок и жертв среди гражданского населения․ Кроме того‚ АСО могут действовать в условиях‚ недоступных для человека‚ например‚ в зонах с высоким уровнем радиации или в глубоком космосе․

Однако‚ противники АСО указывают на то‚ что передача решений о жизни и смерти машинам – это морально неприемлемо․ Кроме того‚ существует риск того‚ что АСО могут быть взломаны или использованы не по назначению; И‚ наконец‚ возникает вопрос о том‚ как обеспечить соблюдение международного гуманитарного права в условиях‚ когда решения принимаются машинами․

- Преимущества:

- Высокая точность и скорость

- Отсутствие эмоций и усталости

- Возможность действовать в опасных условиях

ИИ в Разведке и Анализе Данных: Большой Брат Следит за Тобой?

Искусственный интеллект уже активно используется в разведывательных целях․ Системы распознавания лиц‚ анализа социальных сетей и больших данных позволяют собирать и обрабатывать огромные объемы информации‚ выявлять закономерности и прогнозировать действия потенциальных противников․

Нам кажется‚ что это может привести к тотальной слежке за гражданами‚ нарушению их прав и свобод․ Где проходит граница между необходимостью обеспечения безопасности и вторжением в личную жизнь? И кто будет контролировать использование этих данных? Ведь информация – это сила‚ и в руках недобросовестных людей она может стать оружием․

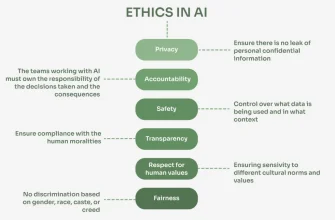

Этические Вопросы Сбора и Использования Данных

Сбор и использование данных‚ особенно личных‚ должны осуществляться с соблюдением строгих этических норм и правил․ Необходимо обеспечить прозрачность‚ подотчетность и возможность для граждан контролировать свои данные․ Кроме того‚ необходимо разработать механизмы защиты от злоупотреблений и дискриминации․

Нам кажется важным‚ чтобы общество активно участвовало в обсуждении этих вопросов и требовало от правительств и корпораций соблюдения прав человека․ Ведь в конечном итоге‚ именно мы‚ граждане‚ должны определять‚ каким будет наше будущее․

Кибервойна и ИИ: Невидимый Фронт

Кибервойна – это еще одна область‚ где искусственный интеллект играет все более важную роль․ ИИ может использоваться для разработки и развертывания кибератак‚ защиты от них‚ а также для анализа и прогнозирования киберугроз․

Нам кажется‚ что кибервойна – это война будущего‚ война‚ которая ведется в невидимом пространстве‚ но может иметь разрушительные последствия для экономики‚ инфраструктуры и безопасности государств․ Использование ИИ в кибервойне делает ее еще более сложной и непредсказуемой․

Проблемы Атрибуции и Ответственности

Одной из главных проблем кибервойны является атрибуция‚ то есть определение того‚ кто стоит за кибератакой․ Использование ИИ может усложнить этот процесс‚ так как злоумышленники могут использовать сложные алгоритмы для маскировки своих действий․

Кроме того‚ возникает вопрос об ответственности за кибератаки․ Если кибератака была совершена с использованием ИИ‚ кто должен нести ответственность: разработчик‚ оператор‚ или сама машина? И как определить‚ была ли атака совершена намеренно или случайно?

"Технологический прогресс‚ как топор в руках преступника‚ просто увеличивает его возможности․" – Цитата Альберта Эйнштейна‚ отражающая двойственность прогресса․

Обучение ИИ: Предвзятость и Дискриминация

Искусственный интеллект обучается на данных‚ и если эти данные содержат предвзятости и дискриминацию‚ то ИИ будет воспроизводить и усиливать их․ Это может привести к тому‚ что ИИ будет принимать несправедливые и дискриминационные решения в военной сфере‚ например‚ при выборе целей или при оценке рисков․

Нам кажется‚ что необходимо уделять особое внимание качеству данных‚ используемых для обучения ИИ‚ и разрабатывать методы борьбы с предвзятостью и дискриминацией․ Кроме того‚ необходимо обеспечить прозрачность и подотчетность алгоритмов ИИ‚ чтобы можно было выявить и исправить ошибки․

Примеры Предвзятости в Военных Приложениях ИИ

Представьте себе систему распознавания лиц‚ которая лучше распознает лица людей определенной расы или пола․ Такая система может приводить к ошибочным задержаниям и обвинениям․ Или представьте себе систему оценки рисков‚ которая предвзято относится к людям определенной национальности или вероисповедания․ Такая система может приводить к несправедливому распределению ресурсов и усилий․

Нам кажется важным‚ чтобы разработчики и пользователи ИИ осознавали эти риски и принимали меры для их предотвращения․ Ведь в конечном итоге‚ мы не хотим‚ чтобы ИИ увековечивал и усиливал неравенство и дискриминацию․

Международное Сотрудничество и Регулирование

Использование искусственного интеллекта в военном деле – это глобальная проблема‚ которая требует международного сотрудничества и регулирования․ Необходимо разработать общие принципы и стандарты‚ которые будут регулировать разработку и использование ИИ в военной сфере․ Кроме того‚ необходимо создать механизмы контроля и проверки соблюдения этих принципов и стандартов․

Нам кажется‚ что международное сообщество должно начать диалог о будущем ИИ в военном деле и выработать общую стратегию‚ которая позволит использовать ИИ для укрепления мира и безопасности‚ а не для разжигания конфликтов․

Роль ООН и Других Международных Организаций

ООН и другие международные организации могут сыграть важную роль в регулировании использования ИИ в военном деле․ Они могут разработать и принять международные договоры и конвенции‚ которые будут устанавливать общие принципы и стандарты․ Кроме того‚ они могут создать механизмы мониторинга и контроля соблюдения этих договоров и конвенций․

Нам кажется важным‚ чтобы Россия активно участвовала в этих процессах и вносила свой вклад в разработку общих правил игры․ Ведь от того‚ как мы сегодня подойдем к этим вопросам‚ зависит будущее всего человечества․

Будущее Войны: Этика и Ответственность

Искусственный интеллект меняет облик войны‚ делая ее более сложной‚ непредсказуемой и опасной․ Нам кажется‚ что необходимо задуматься о том‚ каким мы хотим видеть будущее войны‚ и принять меры для того‚ чтобы ИИ использовался для укрепления мира и безопасности‚ а не для разжигания конфликтов․

Подробнее

| ИИ в военной стратегии | Автономные боевые системы | Этика кибервойны ИИ | Риски предвзятости ИИ | Регулирование ИИ в армии |

|---|---|---|---|---|

| ИИ и международное право | Ответственность за решения ИИ | ИИ в разведывательных операциях | Обучение ИИ для военных | Безопасность ИИ в военном деле |