- Кто в ответе, когда ИИ ошибается? Личный опыт и размышления

- Первые столкновения с ошибками ИИ

- Юридические аспекты ответственности за ошибки ИИ

- Этические дилеммы и ИИ

- Наш личный опыт: Эксперименты с ИИ

- Как минимизировать риски, связанные с ИИ?

- Будущее ИИ: На что нам надеяться?

- Практические советы пользователям ИИ-систем

- Примеры ответственности в различных сферах

- Медицина

- Транспорт

- Финансы

- Будущие исследования и разработки

- Таблица с LSI запросами

Кто в ответе, когда ИИ ошибается? Личный опыт и размышления

В последнее время искусственный интеллект (ИИ) все глубже проникает в нашу жизнь. Он помогает нам в работе, развлекает нас, и даже принимает решения, которые влияют на наше будущее. Но что происходит, когда ИИ ошибается? Кто несет ответственность за последствия этих ошибок? Этот вопрос становится все более актуальным, и мы решили поделиться своим опытом и размышлениями на эту тему.

Мы, как активные пользователи и наблюдатели за развитием ИИ, сталкиваемся с этой проблемой ежедневно. От рекомендаций в онлайн-магазинах, которые совершенно не соответствуют нашим интересам, до более серьезных ситуаций, когда автоматизированные системы принимают неверные решения, влияющие на нашу безопасность и благополучие. Все это заставляет задуматься о том, как правильно регулировать сферу ИИ и как обеспечить защиту прав пользователей.

Первые столкновения с ошибками ИИ

Наш первый серьезный опыт с ошибками ИИ был связан с автоматизированной системой поддержки клиентов. Мы обратились в компанию с проблемой, и вместо квалифицированной помощи получили набор стандартных ответов, которые не имели ничего общего с нашей ситуацией. В итоге, нам пришлось потратить несколько часов на общение с разными операторами, чтобы решить проблему. Этот случай показал нам, что ИИ, несмотря на свою продвинутость, все еще не способен полностью заменить человеческое общение и понимание.

Другой пример – это использование ИИ в медицинских диагностических системах. Мы узнали о случаях, когда такие системы ставили неверные диагнозы, что приводило к неправильному лечению и ухудшению состояния пациентов. Это вызвало у нас серьезные опасения относительно использования ИИ в критически важных областях, где цена ошибки может быть очень высокой.

Юридические аспекты ответственности за ошибки ИИ

Вопрос ответственности за ошибки ИИ становится все более сложным с юридической точки зрения. Кто должен отвечать, если беспилотный автомобиль станет виновником ДТП? Программист, который разработал алгоритм? Производитель автомобиля? Или владелец, который доверил управление ИИ? На данный момент, единого ответа на этот вопрос нет, и законодательство в этой области находится в стадии разработки.

Нам кажется, что необходимо разработать четкие правила и стандарты для разработки и использования ИИ-систем. Эти правила должны учитывать возможные риски и предусматривать механизмы компенсации ущерба в случае ошибок. Важно также, чтобы пользователи имели возможность обжаловать решения, принятые ИИ, и требовать пересмотра этих решений компетентными специалистами.

Этические дилеммы и ИИ

Помимо юридических аспектов, существуют и этические дилеммы, связанные с использованием ИИ. Например, как запрограммировать беспилотный автомобиль, чтобы он принимал решения в ситуациях, когда неизбежны жертвы? Кого он должен спасти: пассажира или пешехода? Эти вопросы не имеют однозначного ответа, и требуют широкого общественного обсуждения.

Мы считаем, что необходимо привлекать к разработке ИИ-систем не только программистов и инженеров, но и философов, этиков и представителей общественности. Только в этом случае мы сможем создать ИИ, который будет соответствовать нашим моральным ценностям и учитывать интересы всех членов общества.

"Искусственный интеллект – это не просто технология, это отражение нашей собственной человечности. Он может быть использован как для добра, так и для зла, и ответственность за это лежит на нас." ⎯ Стивен Хокинг

Наш личный опыт: Эксперименты с ИИ

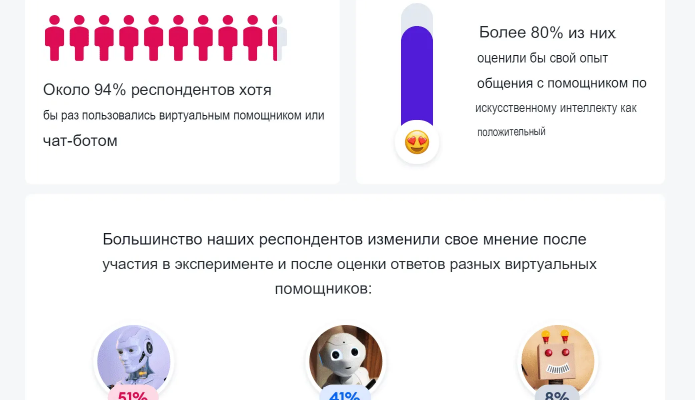

Мы решили провести несколько экспериментов, чтобы лучше понять, как работают ИИ-системы и какие у них есть ограничения. Мы использовали различные инструменты для создания и обучения нейронных сетей, и попытались решить несколько простых задач. Результаты оказались весьма интересными.

Во-первых, мы убедились в том, что ИИ требует огромного количества данных для обучения. Чем больше данных мы предоставляли, тем лучше становились результаты. Во-вторых, мы обнаружили, что ИИ очень чувствителен к качеству данных. Если данные были неполными или содержали ошибки, это негативно сказывалось на работе системы. В-третьих, мы поняли, что ИИ – это не "черный ящик". Мы можем анализировать, как работает нейронная сеть, и понимать, почему она принимает те или иные решения.

Как минимизировать риски, связанные с ИИ?

Мы считаем, что существует несколько способов минимизировать риски, связанные с использованием ИИ:

- Разработка четких стандартов и правил для разработки и использования ИИ-систем.

- Проведение независимой экспертизы ИИ-систем перед их внедрением.

- Обеспечение прозрачности и понятности работы ИИ-систем.

- Создание механизмов компенсации ущерба в случае ошибок ИИ.

- Привлечение общественности к обсуждению этических и социальных вопросов, связанных с ИИ.

Будущее ИИ: На что нам надеяться?

Несмотря на все риски и опасения, мы оптимистично смотрим в будущее ИИ. Мы верим, что ИИ может стать мощным инструментом для решения глобальных проблем, таких как изменение климата, бедность и болезни. Но для этого необходимо, чтобы ИИ развивался в соответствии с нашими моральными ценностями и учитывал интересы всех членов общества.

Мы надеемся, что наша статья поможет вам лучше понять сложные вопросы, связанные с ответственностью за ошибки ИИ. Мы призываем вас к активному участию в обсуждении этих вопросов и к формированию будущего ИИ, которое будет служить на благо всего человечества.

Практические советы пользователям ИИ-систем

Вот несколько практических советов, которые помогут вам минимизировать риски при использовании ИИ-систем:

- Будьте критичны к информации, которую предоставляет ИИ. Не принимайте все на веру.

- Проверяйте решения, принятые ИИ, особенно если они касаются вашей безопасности и благополучия.

- Сообщайте о любых ошибках и неточностях, которые вы заметили в работе ИИ-систем.

- Изучайте принципы работы ИИ, чтобы лучше понимать, как он принимает решения.

- Поддерживайте инициативы, направленные на разработку этичного и ответственного ИИ.

Примеры ответственности в различных сферах

Рассмотрим несколько примеров ответственности за ошибки ИИ в различных сферах:

Медицина

Если ИИ-система ставит неверный диагноз, ответственность может лежать на разработчике системы, враче, который использовал систему, или на медицинском учреждении.

Транспорт

Если беспилотный автомобиль становится виновником ДТП, ответственность может лежать на производителе автомобиля, разработчике алгоритма, или на владельце автомобиля.

Финансы

Если ИИ-система совершает ошибку при управлении инвестициями, ответственность может лежать на финансовой организации, разработчике системы, или на инвесторе.

Будущие исследования и разработки

Мы считаем, что необходимо проводить дальнейшие исследования в области ИИ, направленные на повышение его надежности, безопасности и прозрачности. Важно также разрабатывать новые методы обучения ИИ, которые позволят ему лучше понимать наши потребности и адаптироваться к изменяющимся условиям.

Особое внимание следует уделять разработке этических принципов и стандартов для ИИ, которые будут учитывать интересы всех членов общества. Мы должны стремиться к созданию ИИ, который будет не только умным, но и ответственным.

Таблица с LSI запросами

Подробнее

| Ответственность за ошибки искусственного интеллекта | Юридическая ответственность за ИИ | Этика искусственного интеллекта | Безопасность искусственного интеллекта | Регулирование искусственного интеллекта |

| Последствия ошибок ИИ | ИИ в медицине и ответственность | ИИ в транспорте и ответственность | Ответственность за действия беспилотных автомобилей | Этические дилеммы искусственного интеллекта |