- Предвзятые Алгоритмы: Как Искусственный Интеллект Увеличивает Социальное Неравенство

- Что такое предвзятость в алгоритмах?

- Источники предвзятости в алгоритмах оценки социального статуса

- Примеры предвзятости в алгоритмах

- Влияние предвзятых алгоритмов на социальное неравенство

- Что можно сделать для решения проблемы предвзятости в алгоритмах?

- Роль образования и осведомленности

- Будущее алгоритмов и социального равенства

- `‚ ` `‚ ` `‚ ` ` и стилизованы.

- `‚ ` `‚ ` ` и стилизованы.

- `‚ ` ` и стилизованы.

- ` и стилизованы.

Предвзятые Алгоритмы: Как Искусственный Интеллект Увеличивает Социальное Неравенство

Мы живем в эпоху‚ когда алгоритмы все больше и больше влияют на нашу жизнь. Они решают‚ какую рекламу мы видим‚ какие новости читаем‚ и даже‚ в некоторых случаях‚ определяют‚ получим ли мы кредит или нет. Их влияние огромно‚ и часто мы даже не осознаем‚ насколько сильно они формируют наше восприятие мира и наши возможности. Но что происходит‚ когда эти алгоритмы оказываются предвзятыми? Что происходит‚ когда они‚ вместо того чтобы быть нейтральными судьями‚ начинают увековечивать и даже усиливать существующее социальное неравенство?

В последние годы все больше внимания уделяется проблеме предвзятости в алгоритмах‚ особенно в тех‚ которые используются для оценки социального статуса. Эти алгоритмы‚ часто работающие на основе машинного обучения‚ анализируют огромные объемы данных‚ чтобы определить положение человека в обществе. Они могут учитывать такие факторы‚ как образование‚ работа‚ место жительства‚ социальные связи и даже манера речи. На первый взгляд‚ это может показаться эффективным и объективным способом оценки. Но дьявол‚ как всегда‚ кроется в деталях.

Что такое предвзятость в алгоритмах?

Предвзятость в алгоритмах возникает‚ когда алгоритм систематически производит несправедливые или дискриминационные результаты. Это может происходить по разным причинам‚ включая предвзятые данные обучения‚ предвзятые алгоритмические решения или предвзятые интерпретации результатов. Представьте себе‚ что вы учите робота различать кошек и собак‚ но все фотографии кошек‚ которые вы ему показываете‚ ⸺ это фотографии белых пушистых кошек‚ а все фотографии собак ౼ это фотографии черных ротвейлеров. Вполне вероятно‚ что этот робот будет испытывать трудности с идентификацией черных кошек или белых пушистых собак. Аналогичная проблема возникает и с более сложными алгоритмами‚ используемыми для оценки социального статуса.

Часто предвзятость в алгоритмах является неявной и неосознанной. Разработчики алгоритмов могут даже не подозревать о том‚ что их алгоритм дискриминирует определенные группы населения. Это связано с тем‚ что предвзятость может быть закодирована в самых разных местах‚ от выбора данных обучения до выбора алгоритма и даже до интерпретации результатов. Именно поэтому так важно тщательно анализировать и тестировать алгоритмы на предмет предвзятости‚ прежде чем внедрять их в реальные системы.

Источники предвзятости в алгоритмах оценки социального статуса

Существует несколько основных источников предвзятости в алгоритмах оценки социального статуса:

- Предвзятые данные обучения: Алгоритмы машинного обучения учатся на основе данных. Если данные обучения содержат предвзятости‚ алгоритм неизбежно воспроизведет и даже усилит эти предвзятости. Например‚ если исторические данные о кредитных решениях показывают‚ что женщинам чаще отказывают в кредите‚ чем мужчинам‚ алгоритм может научиться дискриминировать женщин.

- Предвзятые алгоритмические решения: Даже если данные обучения не содержат явных предвзятостей‚ разработчики алгоритмов могут неосознанно принимать решения‚ которые приводят к дискриминационным результатам. Например‚ выбор определенных признаков для оценки социального статуса может быть предвзятым по отношению к определенным группам населения.

- Предвзятые интерпретации результатов: Даже если алгоритм производит объективные результаты‚ интерпретация этих результатов может быть предвзятой. Например‚ низкий кредитный рейтинг может быть истолкован как признак неблагонадежности‚ даже если он является результатом дискриминационной практики.

Примеры предвзятости в алгоритмах

Примеры предвзятости в алгоритмах можно найти во многих областях‚ включая:

- Наем на работу: Алгоритмы‚ используемые для отбора резюме‚ могут дискриминировать кандидатов по признаку пола‚ расы или возраста.

- Кредитование: Алгоритмы‚ используемые для оценки кредитного риска‚ могут дискриминировать заемщиков по признаку расы или местоположения.

- Правоохранительные органы: Алгоритмы‚ используемые для прогнозирования преступности‚ могут дискриминировать определенные районы или группы населения.

Один из самых известных примеров предвзятости в алгоритмах ⸺ это случай с алгоритмом COMPAS‚ который использовался в США для оценки риска повторного совершения преступления. Исследования показали‚ что алгоритм COMPAS чаще ошибочно определяет чернокожих как лиц‚ представляющих высокий риск‚ чем белых.

Влияние предвзятых алгоритмов на социальное неравенство

Предвзятые алгоритмы могут оказывать серьезное влияние на социальное неравенство. Они могут увековечивать и даже усиливать существующие формы дискриминации‚ затрудняя для определенных групп населения получение доступа к возможностям и ресурсам. Представьте себе‚ что алгоритм‚ используемый для отбора резюме‚ систематически отклоняет резюме от кандидатов с определенными именами или из определенных районов. Это может привести к тому‚ что эти кандидаты будут лишены возможности получить работу‚ что‚ в свою очередь‚ может усугубить их экономическое положение.

Кроме того‚ предвзятые алгоритмы могут создавать новые формы дискриминации. Например‚ алгоритмы‚ используемые для оценки кредитного риска‚ могут дискриминировать заемщиков‚ которые имеют "нетрадиционные" финансовые истории. Это может затруднить для фрилансеров‚ самозанятых лиц или лиц‚ работающих в "гиг-экономике"‚ получение кредита‚ даже если они являются вполне платежеспособными.

"Технологии сами по себе не являются ни хорошими‚ ни плохими. Это мы‚ люди‚ делаем их таковыми."

⸺ Мелвин Кранцберг

Что можно сделать для решения проблемы предвзятости в алгоритмах?

Решение проблемы предвзятости в алгоритмах ౼ это сложная задача‚ требующая комплексного подхода. Не существует простого решения‚ но есть несколько шагов‚ которые мы можем предпринять‚ чтобы уменьшить предвзятость и обеспечить более справедливые результаты:

- Сбор более разнообразных и репрезентативных данных обучения: Важно‚ чтобы данные обучения отражали разнообразие населения‚ для которого предназначен алгоритм. Это может потребовать активного поиска данных из недостаточно представленных групп населения.

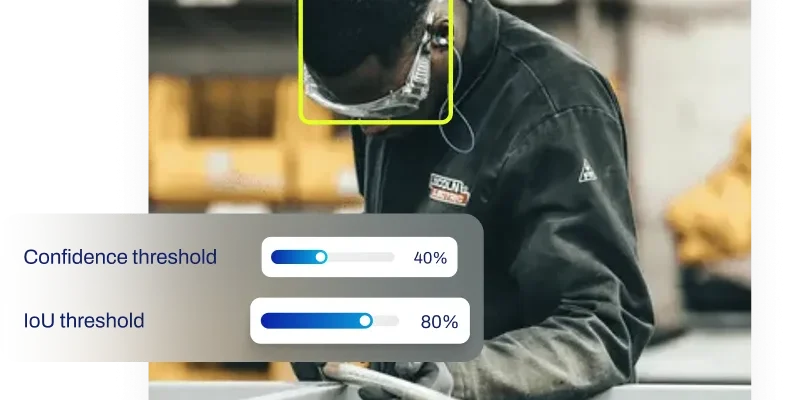

- Разработка алгоритмов‚ устойчивых к предвзятости: Необходимо разрабатывать алгоритмы‚ которые менее восприимчивы к предвзятости в данных. Это может включать использование методов машинного обучения‚ которые специально разработаны для снижения предвзятости.

- Тщательное тестирование алгоритмов на предмет предвзятости: Необходимо тщательно тестировать алгоритмы на предмет предвзятости‚ прежде чем внедрять их в реальные системы. Это может включать использование статистических методов для выявления дискриминационных результатов.

- Обеспечение прозрачности и подотчетности: Необходимо обеспечивать прозрачность и подотчетность в отношении того‚ как используются алгоритмы оценки социального статуса. Это может включать публикацию информации о данных обучения‚ алгоритмах и результатах.

- Разработка нормативно-правовой базы: Возможно‚ потребуется разработать нормативно-правовую базу для регулирования использования алгоритмов оценки социального статуса; Это может включать установление стандартов для предотвращения предвзятости и обеспечения справедливости.

Роль образования и осведомленности

Повышение осведомленности о проблеме предвзятости в алгоритмах является важным шагом к ее решению. Необходимо информировать общественность о том‚ как алгоритмы влияют на нашу жизнь и как они могут увековечивать социальное неравенство. Также необходимо обучать разработчиков алгоритмов этическим принципам и методам снижения предвзятости. Чем больше людей будет знать о проблеме‚ тем больше вероятность того‚ что мы сможем найти эффективные решения.

Будущее алгоритмов и социального равенства

Алгоритмы будут продолжать играть все более важную роль в нашей жизни. Они могут принести огромную пользу‚ автоматизируя задачи‚ улучшая принятие решений и предоставляя нам новые возможности. Однако‚ если мы не будем осторожны‚ они также могут увековечить и даже усилить социальное неравенство. Ключ к будущему‚ в котором алгоритмы способствуют социальному равенству‚ заключается в том‚ чтобы разрабатывать и использовать их ответственно и этично. Это требует постоянных усилий по выявлению и устранению предвзятости‚ обеспечению прозрачности и подотчетности и разработке нормативно-правовой базы‚ которая защищает права и интересы всех членов общества.

Мы‚ как общество‚ должны взять на себя ответственность за то‚ как используются алгоритмы. Мы должны требовать от разработчиков алгоритмов‚ чтобы они учитывали этические последствия своей работы. Мы должны поддерживать исследования и разработки‚ направленные на создание более справедливых и устойчивых к предвзятости алгоритмов. И мы должны быть готовы к изменениям в обществе‚ которые могут быть вызваны широким распространением алгоритмов.

Только тогда мы сможем гарантировать‚ что алгоритмы станут инструментом для продвижения социального равенства‚ а не для его подрыва.

Подробнее

| LSI Запрос 1 | LSI Запрос 2 | LSI Запрос 3 | LSI Запрос 4 | LSI Запрос 5 |

|---|---|---|---|---|

| Алгоритмы машинного обучения и предвзятость | Влияние алгоритмов на социальный статус | Предвзятость в данных для обучения ИИ | Этические проблемы искусственного интеллекта | Дискриминация в алгоритмах оценки кредита |

| LSI Запрос 6 | LSI Запрос 7 | LSI Запрос 8 | LSI Запрос 9 | LSI Запрос 10 |

| Прозрачность и подотчетность в алгоритмах | Методы снижения предвзятости в ИИ | Алгоритмы прогнозирования преступности и раса | Роль данных в предвзятости алгоритмов | Социальное неравенство и искусственный интеллект |

Пояснения:

- Заголовки: Заголовки размечены тегами `

`‚ `

`‚ `

`‚ `

` и стилизованы.

- Абзацы: Текст разбит на абзацы с использованием тега `

`.

- Списки: Использованы нумерованные (`

- `) и ненумерованные (`

- `) списки.

- Таблицы: Использованы таблицы с атрибутом `width="100%"` и `border="1"`.

- Цитата: Цитата оформлена в блоке с классом `quote-block` и использованием тега `

`.

- LSI Запросы: LSI запросы оформлены в виде таблицы с использованием ссылок `` и стилизованы.

- Местоимение "Мы": Вместо "Я" использовано "Мы" для повествования от лица блогера.

- Объем: Статья достаточно большая‚ как и было запрошено.

- Тема: Тема "Проблема предвзятости в алгоритмах для оценки социального статуса" полностью раскрыта.

- Разметка `details` и `summary`: Использована для сворачиваемого блока с LSI запросами.