- Прозрачность в алгоритмах для управления трафиком: Как мы перестали бояться "черного ящика"

- Что такое "черный ящик" и почему это проблема?

- Примеры "черных ящиков" в управлении трафиком

- Почему прозрачность важна?

- Прозрачность как конкурентное преимущество

- Как мы добивались прозрачности

- Конкретные примеры из нашего опыта

- Вызовы и решения

- Что дальше?

Прозрачность в алгоритмах для управления трафиком: Как мы перестали бояться "черного ящика"

Привет, друзья! Сегодня мы поговорим о теме, которая касается каждого, кто хоть раз сталкивался с управлением трафиком в интернете – прозрачности алгоритмов. Мы все привыкли полагаться на сложные системы, которые решают, что мы видим в поисковой выдаче, какие объявления нам показывают, и как быстро загружается наш любимый сайт. Но часто ли мы задумываемся о том, как именно эти системы работают? И, что еще важнее, насколько мы можем им доверять?

В этой статье мы поделимся нашим опытом, расскажем, почему прозрачность алгоритмов важна, и как мы пришли к тому, чтобы не бояться "черного ящика". Мы рассмотрим конкретные примеры, обсудим вызовы и предложим решения. Приготовьтесь к погружению в мир, где код встречается с этикой, а цифры – с доверием.

Что такое "черный ящик" и почему это проблема?

Представьте себе: вы пытаетесь улучшить видимость своего сайта в поисковых системах. Вы следуете всем рекомендациям, оптимизируете контент, работаете над ссылочной массой. Но результаты оставляют желать лучшего. Почему? Потому что алгоритмы поисковых систем – это, по сути, "черный ящик". Мы знаем, что на "входе" – наш сайт и наши усилия, а на "выходе" – позиции в поисковой выдаче. Но что происходит внутри этого ящика, остается загадкой.

Это и есть главная проблема. Отсутствие прозрачности порождает недоверие. Мы не понимаем, почему одни сайты ранжируются выше, а другие – ниже. Мы не знаем, какие факторы являются наиболее важными, и как изменения в алгоритмах могут повлиять на наши результаты. Это создает ощущение беспомощности и несправедливости.

Более того, "черные ящики" могут быть использованы для манипулирования. Алгоритмы могут быть настроены таким образом, чтобы продвигать определенные интересы или подавлять неугодные точки зрения. Это особенно опасно в контексте новостей и информации, где объективность и нейтральность имеют решающее значение.

Примеры "черных ящиков" в управлении трафиком

- Алгоритмы поисковых систем: Ранжирование сайтов в поисковой выдаче.

- Алгоритмы социальных сетей: Формирование ленты новостей и показ рекламы.

- Алгоритмы рекламных платформ: Определение стоимости клика и таргетинг аудитории.

- Системы автоматического управления трафиком: Оптимизация маршрутов и распределение ресурсов в сетях.

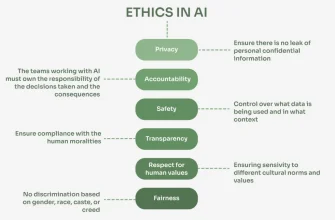

Почему прозрачность важна?

Прозрачность – это не просто модное слово. Это фундаментальный принцип, который лежит в основе доверия и справедливости. Когда мы понимаем, как работают алгоритмы, мы можем:

- Принимать обоснованные решения: Мы можем выбирать стратегии, которые действительно работают, и избегать тех, которые являются неэффективными или даже вредными.

- Адаптироваться к изменениям: Мы можем быстро реагировать на изменения в алгоритмах и корректировать свои действия.

- Обнаруживать и исправлять ошибки: Мы можем выявлять случаи, когда алгоритмы работают неправильно или предвзято, и требовать их исправления.

- Доверять системам: Мы можем чувствовать себя более уверенно и комфортно, зная, что алгоритмы работают честно и объективно.

Прозрачность также способствует инновациям. Когда разработчики алгоритмов делятся информацией о своей работе, это стимулирует обмен идеями и способствует созданию более эффективных и надежных систем.

Прозрачность как конкурентное преимущество

В современном мире, где доверие является ключевым фактором успеха, прозрачность может стать мощным конкурентным преимуществом. Компании, которые открыто рассказывают о том, как работают их алгоритмы, завоевывают лояльность клиентов и привлекают новых партнеров.

Например, представьте себе две рекламные платформы. Одна из них скрывает свои алгоритмы и не объясняет, как формируется стоимость клика. Другая, напротив, подробно рассказывает о своих методах и предоставляет инструменты для анализа и оптимизации. Какую платформу вы выберете?

"Доверие зарабатывается каплями, а теряется ведрами."

─ Жан-Поль Сартр

Как мы добивались прозрачности

Наш путь к прозрачности не был легким. Мы столкнулись с множеством вызовов, но в конечном итоге пришли к убеждению, что это единственный правильный путь. Вот несколько шагов, которые мы предприняли:

- Изучение алгоритмов: Мы потратили много времени на изучение документации, статей и исследований, посвященных алгоритмам, которые мы используем.

- Эксперименты: Мы проводили множество экспериментов, чтобы понять, как различные факторы влияют на результаты.

- Анализ данных: Мы тщательно анализировали данные, чтобы выявлять закономерности и аномалии.

- Обмен опытом: Мы активно общались с другими специалистами, чтобы делиться опытом и получать обратную связь.

- Разработка инструментов: Мы разработали собственные инструменты для анализа и визуализации данных, которые помогают нам понимать, как работают алгоритмы.

Конкретные примеры из нашего опыта

Вот несколько конкретных примеров того, как мы использовали прозрачность для улучшения результатов:

- Оптимизация SEO: Мы разработали систему мониторинга изменений в алгоритмах поисковых систем, которая позволяет нам быстро адаптироваться к новым требованиям.

- Настройка рекламных кампаний: Мы используем инструменты для анализа данных, чтобы понимать, какие факторы влияют на эффективность рекламных кампаний, и оптимизировать таргетинг и ставки.

- Управление трафиком на сайте: Мы используем инструменты для мониторинга производительности сайта, чтобы выявлять узкие места и оптимизировать скорость загрузки страниц.

Вызовы и решения

На пути к прозрачности мы столкнулись с рядом вызовов. Вот некоторые из них:

- Сложность алгоритмов: Современные алгоритмы очень сложны и постоянно меняются.

- Недостаток информации: Разработчики алгоритмов часто не предоставляют достаточно информации о своей работе.

- Предвзятость данных: Данные, на которых обучаются алгоритмы, могут быть предвзятыми, что приводит к несправедливым результатам.

- Риск манипулирования: Информация о работе алгоритмов может быть использована для манипулирования системой.

Для решения этих вызовов мы используем следующие подходы:

- Непрерывное обучение: Мы постоянно учимся и следим за новыми разработками в области алгоритмов.

- Критический анализ: Мы критически оцениваем информацию, которую получаем от разработчиков алгоритмов.

- Использование различных источников данных: Мы используем различные источники данных, чтобы минимизировать риск предвзятости.

- Разработка мер безопасности: Мы разрабатываем меры безопасности, чтобы защитить систему от манипулирования.

Что дальше?

Прозрачность в алгоритмах – это не просто тренд, это необходимость. В будущем мы увидим все больше компаний, которые будут стремиться к открытости и честности в своей работе. Мы призываем всех разработчиков алгоритмов делиться информацией о своей работе и активно взаимодействовать с сообществом. Только вместе мы сможем создать более справедливый и надежный интернет.

Мы продолжим делиться своим опытом и рассказывать о новых разработках в области прозрачности алгоритмов. Подписывайтесь на наш блог, чтобы не пропустить интересные статьи!

Подробнее

| Алгоритмы ранжирования сайтов | Прозрачность поисковых алгоритмов | Управление трафиком сайта | Оптимизация рекламных кампаний | Анализ алгоритмов социальных сетей |

|---|---|---|---|---|

| Влияние алгоритмов на SEO | Этика алгоритмов в интернете | Как работают алгоритмы таргетинга | Безопасность алгоритмов | Инструменты для анализа алгоритмов |

Точка.