- Раскрывая Черный Ящик: Как Понять и Доверять Машинному Обучению

- Что такое Прозрачность Алгоритмов Машинного Обучения?

- Зачем Нужна Прозрачность?

- Проблемы "Черного Ящика"

- Подходы к Достижению Прозрачности

- Разработка Интерпретируемых Моделей

- Методы Объяснения (Explainable AI ― XAI)

- Визуализация Данных и Моделей

- Аудит Алгоритмов

- Вызовы и Ограничения

- Будущее Прозрачности Алгоритмов

Раскрывая Черный Ящик: Как Понять и Доверять Машинному Обучению

В эпоху искусственного интеллекта и машинного обучения, мы все чаще сталкиваемся с системами, принимающими решения, которые влияют на нашу жизнь․ От одобрения кредита до рекомендаций фильмов, алгоритмы машинного обучения играют все более важную роль․ Но как часто мы задумываемся о том, как эти алгоритмы работают? Насколько мы понимаем логику, лежащую в основе их решений? И, самое главное, можем ли мы им доверять?

Мы, как пользователи и потребители технологий, заслуживаем знать, как функционируют эти сложные системы․ Прозрачность алгоритмов машинного обучения – это не просто модное словосочетание, это необходимость для обеспечения справедливости, ответственности и доверия в мире, где технологии становятся все более всепроникающими․ В этой статье мы исследуем концепцию прозрачности, рассмотрим различные подходы к ее достижению и обсудим вызовы, с которыми сталкиваются разработчики и исследователи․

Что такое Прозрачность Алгоритмов Машинного Обучения?

Прозрачность алгоритмов машинного обучения – это концепция, охватывающая несколько аспектов, связанных с пониманием и интерпретацией работы этих алгоритмов․ В первую очередь, это понимание входных данных, которые алгоритм использует для обучения и принятия решений․ Во-вторых, это понимание логики, по которой алгоритм обрабатывает эти данные и приходит к определенным выводам․ И, наконец, это понимание причин, по которым алгоритм принял то или иное решение в конкретной ситуации․

Прозрачность не означает, что мы должны понимать каждую строку кода, лежащую в основе алгоритма․ Скорее, речь идет о том, чтобы иметь возможность объяснить, почему алгоритм принял то или иное решение, какие факторы повлияли на это решение и как можно повлиять на результат․ Это позволяет нам оценивать справедливость, надежность и этичность алгоритмов, а также выявлять и исправлять потенциальные ошибки и предвзятости․

Зачем Нужна Прозрачность?

Существует множество причин, по которым прозрачность алгоритмов машинного обучения имеет решающее значение:

- Подотчетность: Если алгоритм принимает решение, которое влияет на жизнь человека, важно, чтобы была возможность понять, почему это решение было принято и кто несет ответственность за его последствия․

- Справедливость: Прозрачность позволяет выявлять и устранять предвзятости в алгоритмах, которые могут приводить к дискриминационным результатам․

- Доверие: Когда мы понимаем, как работает алгоритм, мы больше доверяем его решениям․

- Улучшение: Прозрачность помогает разработчикам выявлять слабые места в алгоритмах и улучшать их производительность․

- Соответствие нормативным требованиям: Во многих отраслях, таких как финансы и здравоохранение, существует законодательство, требующее прозрачности алгоритмов, используемых для принятия важных решений․

Проблемы "Черного Ящика"

Многие современные алгоритмы машинного обучения, особенно те, которые основаны на глубоком обучении, часто называют "черными ящиками"․ Это означает, что их внутренняя работа очень сложна и трудно поддается интерпретации․ Мы можем видеть входные данные и выходные результаты, но не можем понять, как алгоритм пришел к этим результатам․ Это создает ряд проблем:

- Невозможность отладки: Если алгоритм выдает неправильные результаты, трудно понять, в чем причина ошибки и как ее исправить․

- Риск предвзятости: Алгоритм может быть предвзятым, даже если разработчики не имели намерения создать предвзятый алгоритм․ Это может произойти из-за предвзятых данных, используемых для обучения алгоритма․

- Невозможность объяснения: Если алгоритм принимает решение, которое влияет на жизнь человека, трудно объяснить этому человеку, почему было принято именно такое решение․

Подходы к Достижению Прозрачности

Существует несколько подходов к достижению прозрачности алгоритмов машинного обучения․ Они варьируются от разработки более простых и интерпретируемых моделей до использования методов объяснения, которые помогают понять, как работают сложные модели․

Разработка Интерпретируемых Моделей

Один из способов достижения прозрачности – это использование моделей, которые по своей природе более интерпретируемы․ Примеры таких моделей:

- Линейные модели: Линейная регрессия и логистическая регрессия легко интерпретируются, поскольку влияние каждой переменной на результат можно легко оценить․

- Деревья решений: Деревья решений представляют собой графическую структуру, которая показывает, как алгоритм принимает решения на основе различных условий․

- Правила ассоциации: Правила ассоциации выявляют закономерности в данных и представляют их в виде простых правил "если-то"․

Хотя эти модели могут быть менее точными, чем более сложные модели, они обеспечивают большую прозрачность и позволяют лучше понимать, как алгоритм принимает решения․

Методы Объяснения (Explainable AI ― XAI)

Когда использование сложных моделей неизбежно, можно использовать методы объяснения, которые позволяют понять, как работают эти модели․ Некоторые из наиболее популярных методов XAI включают:

- LIME (Local Interpretable Model-agnostic Explanations): LIME создает локальные интерпретируемые модели, которые объясняют, как работает сложная модель в окрестности конкретного примера․

- SHAP (SHapley Additive exPlanations): SHAP использует концепцию значений Шепли из теории игр для оценки вклада каждой переменной в результат модели․

- Feature Importance: Методы оценки важности признаков позволяют определить, какие переменные оказывают наибольшее влияние на результат модели․

Эти методы позволяют нам "заглянуть" внутрь "черного ящика" и понять, какие факторы влияют на решения, принимаемые сложными алгоритмами․

"Прозрачность и интерпретируемость машинного обучения – это не просто академические вопросы, это фундаментальные требования для построения доверия и обеспечения справедливости в мире, управляемом алгоритмами․" ‒ Дженнифер Чайес, профессор Калифорнийского университета в Беркли․

Визуализация Данных и Моделей

Визуализация данных и моделей может значительно улучшить понимание их работы․ Например, можно визуализировать:

- Распределение данных: Гистограммы и диаграммы рассеяния помогают понять, как распределены данные и какие закономерности в них присутствуют․

- Структуру модели: Графическое представление структуры нейронной сети или дерева решений может помочь понять, как работает модель․

- Результаты модели: Визуализация результатов модели, например, в виде тепловых карт или графиков, может помочь понять, как модель принимает решения․

Хорошо продуманные визуализации могут сделать сложные алгоритмы более понятными и доступными․

Аудит Алгоритмов

Аудит алгоритмов – это процесс независимой оценки алгоритма на предмет предвзятости, справедливости и соответствия нормативным требованиям․ Аудит может проводиться как внутренними командами, так и внешними экспертами․ Результаты аудита могут быть использованы для выявления и устранения проблем, а также для повышения доверия к алгоритму․

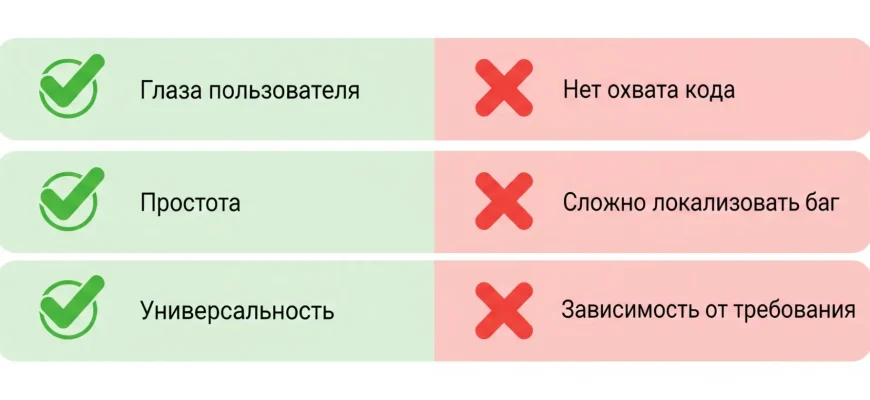

Вызовы и Ограничения

Достижение прозрачности алгоритмов машинного обучения – это сложная задача, сопряженная с рядом вызовов и ограничений:

- Компромисс между точностью и интерпретируемостью: Как правило, более сложные модели, такие как глубокие нейронные сети, обеспечивают более высокую точность, но при этом менее интерпретируемы, чем более простые модели․

- Вычислительная сложность: Некоторые методы объяснения, такие как SHAP, могут быть вычислительно сложными и требовать значительных ресурсов․

- Субъективность: Интерпретация результатов модели может быть субъективной и зависеть от опыта и знаний эксперта․

- Конфиденциальность: В некоторых случаях, раскрытие информации о том, как работает алгоритм, может нарушить конфиденциальность данных или коммерческую тайну․

Несмотря на эти вызовы, важно продолжать исследования и разработки в области прозрачности алгоритмов машинного обучения․ Это необходимо для построения доверия, обеспечения справедливости и ответственности в мире, где технологии играют все более важную роль․

Будущее Прозрачности Алгоритмов

В будущем мы можем ожидать дальнейшего развития методов XAI, а также появления новых подходов к достижению прозрачности․ Важным направлением является разработка автоматизированных инструментов, которые позволяют оценивать и объяснять работу алгоритмов машинного обучения․ Также, все больше внимания будет уделяться вопросам этики и социальной ответственности при разработке и использовании алгоритмов․

Мы надеемся, что эта статья помогла вам лучше понять концепцию прозрачности алгоритмов машинного обучения и ее важность․ Мы призываем вас задавать вопросы, требовать объяснений и участвовать в дискуссиях о будущем технологий и их влиянии на нашу жизнь․ Только вместе мы можем построить мир, где технологии служат нам, а не наоборот․

Подробнее

| Интерпретируемость машинного обучения | Объяснимый искусственный интеллект (XAI) | Прозрачность нейронных сетей | Аудит алгоритмов машинного обучения | Справедливость в машинном обучении |

|---|---|---|---|---|

| Предвзятость в алгоритмах | LIME (Local Interpretable Model-agnostic Explanations) | SHAP (SHapley Additive exPlanations) | Визуализация машинного обучения | Этика машинного обучения |